Um aus Rohdaten echte Steuerungsinformationen zu gewinnen, müssen erfasste Daten schnell und effektiv analysiert werden. Das ist im Grunde auch nichts Neues. Neu sind die Datenmengen aus immer mehr Sensoren und anderen IoT-Komponenten sowie die hohe Rechenleistung, mit der die Auswertung erst ermöglicht wird.

Erkenntnisse in Echtzeit

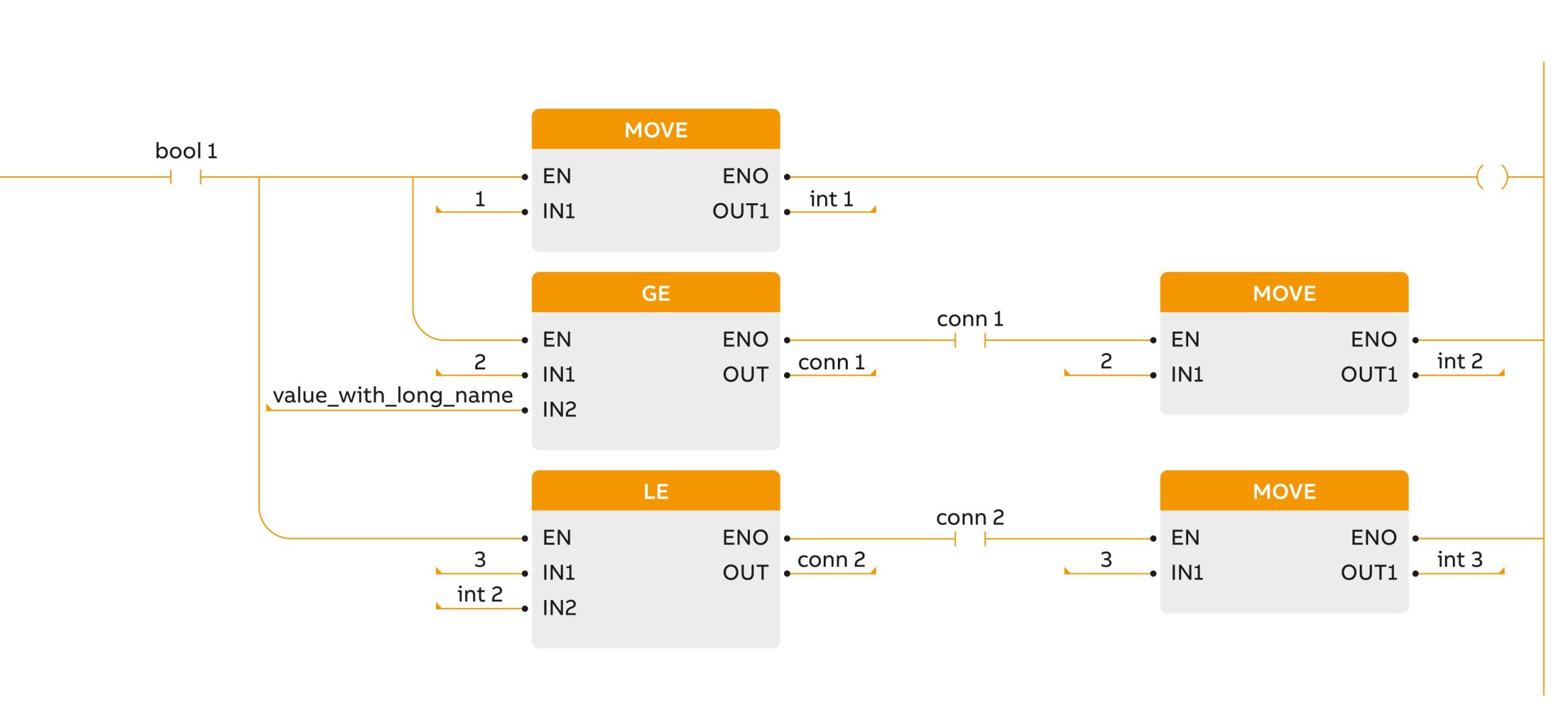

Während man Daten früher nur mit einiger Zeitverzögerung im Batch-Verfahren aktualisiert hat – und z.B. eine Suche nach Fehlern daher erst nach Ausfällen stattfand -, kann man sie heute in Echtzeit überwachen. Das funktioniert mit einer sogenannten Event Stream Processing Engine: Der Kleinrechner filtert Sensordaten direkt am Entstehungsort nach Relevanz. So werden Zeitverluste vermieden, die sonst entstehen, wenn die Daten erst übertragen und gespeichert werden. Nur die wirklich nützlichen Messwerte werden – bereits qualifiziert und gekennzeichnet – übertragen. Damit können Mitarbeiter unmittelbar auf Auffälligkeiten in den Daten reagieren.

KI für Qualitätsmanagement und Instandhaltung

Machine-Learning-Technologie erkennt eigenständig Zusammenhänge in den Daten. Analytische Modelle werden dabei anhand von Beispieldaten mit maschinellem Lernen trainiert. Das System lernt aus den spezifischen Fällen und kann diese nach der Lernphase verallgemeinern. Es werden aber nicht einfach die Beispiele auswendig gelernt, sondern Muster und Gesetzmäßigkeiten in den Lerndaten erkannt. So kann das System im Anschluss auch unbekannte Daten beurteilen. Auf dieser Basis gibt es dann Empfehlungen oder frühzeitig Warnungen heraus, wenn beispielsweise erste Anzeichen für einen potenziellen Ausfall oder Qualitätseinbußen vorhanden sind. Hinzugezogen werden mittels Lifecycle Analytics auch externe Daten etwa aus dem Servicebereich oder aus Produktbewertungen in Social-Media-Kanälen. Diese Informationen fließen dann sofort in den Produktionsprozess ein.

Beispiel aus der Praxis

Sind an die analytische Plattform auch die ERP-Systeme angebunden, kann der gesamte Fertigungsprozess entsprechend reguliert werden: Wenn zum Beispiel Vertriebsdaten zeigen, dass die produzierte Stückzahl zu hoch ist oder ein bestimmter Auftrag höhere Priorität hat, lassen sich der Maschineneinsatz sofort anpassen und Abläufe mit Zulieferern und Logistikdienstleistern exakt abstimmen. Gleichzeitig entfallen umständliche Kommunikationswege, denn alle Mitarbeiter haben überall und zu jeder Zeit die gleiche Sicht auf die Produktion. Insgesamt führt die Datenauswertung so zu hoher Maschinenauslastung, geringem Ausfallrisiko und zu niedrigen Kosten – auch durch konstantere Fertigungsqualität und geringere Ausschussraten. Ein konkretes Beispiel: Der Stahlerzeuger Posco reduzierte durch die Analyse physikalischer Prozesse den Ausschuss bei warmgewalzten Stahlbändern von 15 auf fünf Prozent. Mit herkömmlichen – nachträglich angewandten – statistischen Verfahren war das nicht zu realisieren.