Die Standzeit von Werkzeugen schwankt chargenabhängig teilweise um mehr als 50 Prozent. Um Brüche und ungeplante Stillstandzeiten zu vermeiden, wird daher häufig empfohlen, Werkzeuge nach nur 50 bis 80 Prozent der durchschnittlichen Standzeit zu wechseln. Hierdurch entstehen erhöhte Rüst- und Werkzeugkosten. Eine Verschleißüberwachung bietet Potenzial, die technisch mögliche Standzeit der Werkzeuge auszunutzen und so auch das Risiko für Werkzeugbrüche zu minimieren. Ein Ansatz für die Überwachung des Verschleißes sind steuerungsinterne Prozessdaten. Diese Signale ermöglichen allerdings keine Aussagen über die Verschleißform oder den Zustand einzelner Schneiden. Eine kamerabasierte Überwachung des Werkzeugverschleißes erlaubt hingegen eine besonders genaue Verschleißprognose. So kann neben dem Verschleißgrad auch die Verschleißform bestimmt und eine Handlungsempfehlung zur Anpassung des Prozesses gegeben werden.

Das hier vorgestellte Umsetzungsprojekt wird im Rahmen des vom BMBF geförderten Projektes ProKI zusammen mit RSConnect durchgeführt. Dabei wird, neben Umsetzungsprojekten, auch ein Demonstrations- und Transfernetzwerk für KI in der Produktion aufgebaut, um Unternehmen das Potential von KI aufzuzeigen. Ziel ist es, ein KI-Modell zu trainieren, welches im Anschluss auf der Hardware des Projektpartners ausgeführt wird, um Werkzeugverschleiß ohne Ausbau des Werkzeugs überwachen zu können. Die ersten Schritte umfassen die Integration und die automatisierte Steuerung des verwendeten Kamerasystems auch für Siemens-Steuerungen, sodass die händische Bildaufnahme entfällt.

Vernetzung der Komponenten

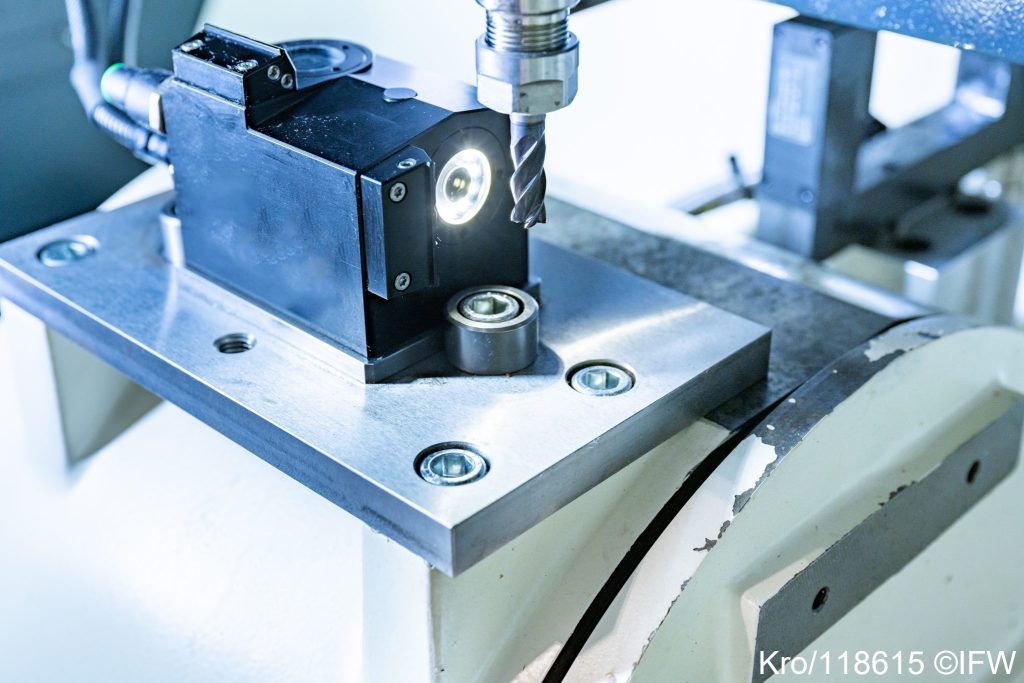

Die Integration der Hard- und Softwarekomponenten erfolgt im KI-Experimentierfeld am IFW in Hannover. Das KI-Experimentierfeld bietet Unternehmen die Möglichkeit, KI-Anwendungen zu erproben sowie Integrationstests eigener Hard- und Softwareapplikationen durchzuführen. Es basiert auf einem Fünfachs-Bearbeitungszentrum des Typs Milltap 700 der DMG Mori mit einer Siemens Sinumerik 840D SL Steuerung, mehreren Recheneinheiten und einer nachgelagerten Kuka-Zelle, sodass eine vollautomatische Produktion möglich ist. Für die Bildaufnahme wird eine Heidenhain VT121 Kamera in die Maschine integriert, die über zwei Linsen verfügt. So können Bilder vom Werkzeug in der Seitenansicht und von unten aufgenommen werden. Montiert wird die Kamera auf dem Maschinentisch, da das Nullpunktspannsystem auf dem Arbeitstisch für die Bearbeitung genutzt wird.

Für die automatisierte Steuerung der Kamera wird der OPC-UA-Server der zur Kamera gehörenden VTC-Steuerungssoftware mit einem Embedded-Computer (Grey.Box von RSConnect) angesprochen. Über das Embedded System ist es möglich, die VTC-Software automatisiert zu bedienen, d.h. eine händische Steuerung der Kamera entfällt. Über einen weiteren OPC-UA-Client innerhalb der Grey.Box wird der OPC-UA-Server der Maschine angesteuert. Technologisch bedingt ist eine direkte Kommunikation der OPC-UA-Server nicht möglich. Das Embedded-System dient als Brücke zwischen den beiden Servern, die Bildaufnahme kann so vollautomatisiert im NC-Code gestartet werden. Im Anwendungsfall reicht lediglich eine Verbindung zum Netzwerk in dem sich die Maschine, die Box sowie der Windows-PC mit der VTC-Software befinden. Die Kameraverbindung im Netzwerk erfolgt über eine GigE-Verbindung.

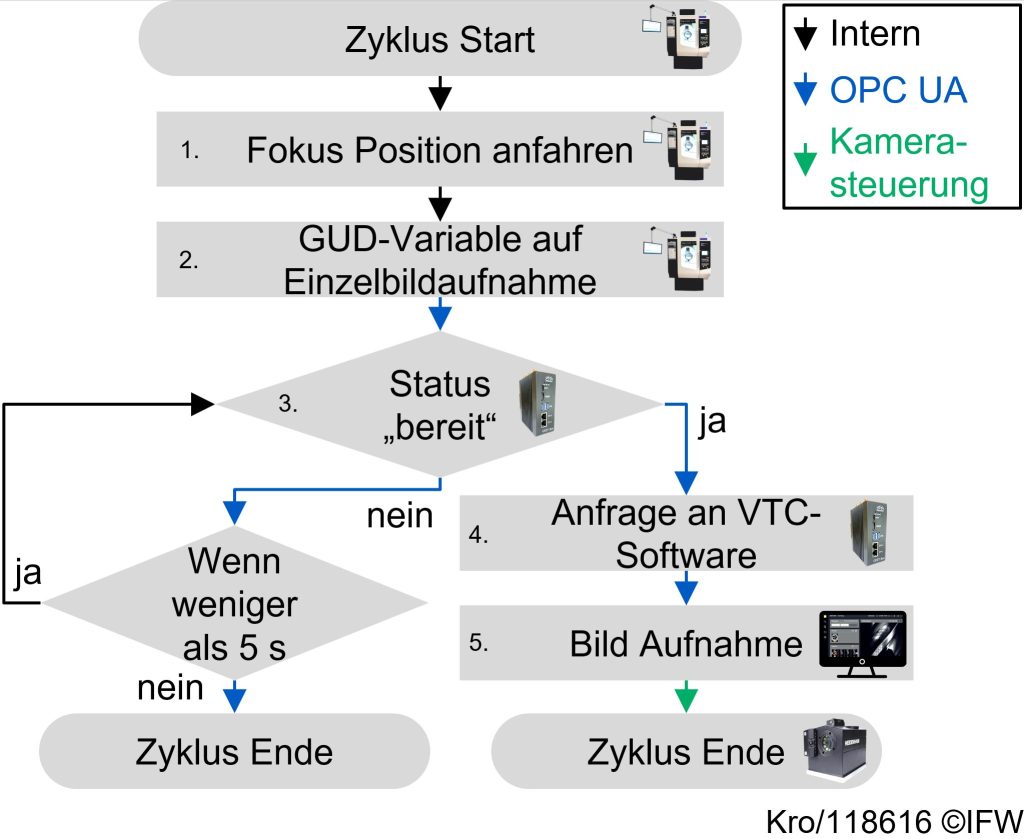

Automatischen Bildaufnahme

Für die automatische Aufnahme von Bildern während der Bearbeitung werden NC-Zyklen benötigt. Die Bildaufnahme kann dann mit einer einzelnen Zeile im NC-Code ausgelöst werden. Um verschiedene Funktionen der Kamera (z.B. Beleuchtung, Einzelbildaufnahme oder Panaromabilder) zu aktivieren, wurden verschiedene Zyklen vom IFW zusammen mit dem Unternehmen Dr. Johannes Heidenhain entwickelt. Nachfolgend wird beispielhaft der Ablauf des Zyklus zur Einzelbildaufnahme erläutert. In dem Zyklus werden Global User Data (GUD)-Variablen verwendet, die von der Grey.Box interpretiert werden. Dieser Variablentyp kann über OPC UA ausgelesen und geschrieben werden und ermöglicht, dass sowohl Zahlenwerte als auch Buchstabenfolgen übermittelt werden können. Die Abfolge zur Bildaufnahme lässt sich in fünf Schritte unterteilen. Im ersten Schritt wird das Werkzeug vor der Kamera in Position gefahren. Anschließend wird über eine GUD-Variable die Anfrage für eine Bildaufnahme im NC-Code gesetzt. Registriert die Grey.Box die Anfrage für eine Bildaufnahme, wird überprüft, ob alle Systemkomponenten aktiv und bereit sind. Dies umfasst die Kamera, die VTC-Software und die Maschine. Ist dies der Fall, wird im vierten Schritt die Anfrage für eine Bildaufnahme an den OPC-UA-Server der VTC Software übermittelt. Diese löst im fünften Schritt die Bildaufnahme aus.

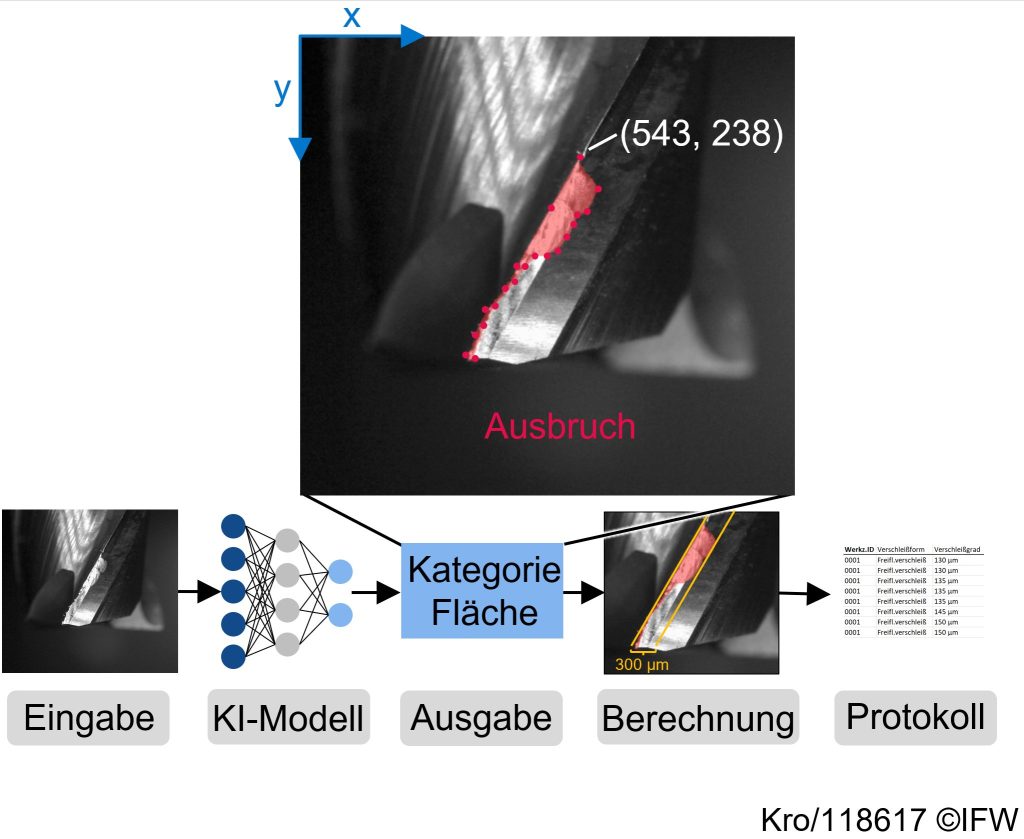

KI-Modell zur Verschleißschätzung

Mit dem entwickelten System wurde bereits ein erster Datensatz aufgenommen, der Bilddaten von Werkzeugen mit variierendem Verschleißzustand enthält. Das nachfolgende Bild zeigt ein Beispiel aus dem Datensatz (Eingabe). Des Weiteren wird ein Ausblick auf die weiteren geplanten Schritte gezeigt. Das Live-Bild (Eingabe) soll im nächsten Schritt auf die Grey.Box übertragen werden. Außerdem übertragen wird einmalig ein vorab trainiertes KI-Modell. Für das Training wird der Datensatz um weitere Verschleißformen erweitert und die Bilddaten gelabelt. Das trainierte Modell erkennt und quantifiziert dann die verschlissene Fläche sowie zukünftig die Verschleißform (Kategorie). Auf Grundlage der segmentierten Fläche kann dann der Verschleißgrad berechnet und ein Protokoll der Verschleißform und der Verschleißentwicklung erstellt werden. Aus diesem Protokoll können dann Handlungsempfehlungen abgeleitet werden.