Unregelmäßigkeiten in einer Schweißnaht können zu einer Minderung der Verbindungsfestigkeit führen. Aus diesem Grund kommt in der automobilen Karosseriefertigung der Überwachung der Fügequalität eine Schlüsselposition zu. Nach dem Stand der Technik haben sich hierfür zwei zerstörungsfreie Methoden etabliert. Die erste Möglichkeit ist die visuelle Beurteilung der Naht durch einen Mitarbeiter. Er prüft manuell auf Sicht, ob die Schweißnaht den geforderten Qualitätskriterien entspricht. Der Prüfaufwand ist hoch. Eine Untersuchung hat ergeben, dass die Visualisierung bis zu 70 Prozent der Gesamtprozesskosten ausmachen. Zudem können die Prüfergebnisse aufgrund der fehlenden Dokumentation nicht weiterverwendet werden. Die zweite Möglichkeit beruht auf die automatisierte Erfassung der Nahtoberfläche, etwa durch Lasertriangulationssysteme. Hierbei wird die Oberflächengeometrie der Schweißnaht erfasst und auf Unregelmäßigkeiten untersucht. Die Prüfsysteme werden unmittelbar neben dem Schweißbrenner positioniert. Nachteil dieser Methode sind die hohen Systemkosten und die konstruktive Einschränkung der Zugänglichkeit zur Fügestelle.

KI als smarte Alternative

Aus diesem Grund werden im Bereich der Forschung und Entwicklung neue Ansätze untersucht, mit dem Ziel anhand von verschiedenen Prozessdaten den Schweißvorgang zu Überwachen oder die Qualität zu ermitteln. Die Komplexität ist aufgrund der Vielzahl an Prozessinformationen und der komplexen physikalischen Vorgänge im Lichtbogen sowie Schmelzbad jedoch sehr hoch. Eine zusammenhängende Betrachtung und Modellierung dieser Daten scheinen auf Basis von experimentellen Untersuchungen sowie menschlicher Schlussfolgerungen unmöglich. Vielversprechender ist der Einsatz von modernen Algorithmen aus dem Bereich der künstlichen Intelligenz, welche in den letzten Jahren weitreichende Fortschritte gemacht haben. Mittels maschinellen Lernens können so Modelle trainiert werden, die anhand von Trainingsdaten die Zusammenhänge zwischen den Prozessdaten und der Qualität ermitteln. Um dieses Werkzeug jedoch sinnvoll nutzen zu können, ist eine große und gut dokumentierte Datenbasis erforderlich. Im Falle des Lichtbogenschweißens setzt sich diese aus den Prozessinformationen vor, während und nach dem Schweißvorgang zusammen. Damit keine Informationen des hochdynamischen Prozesses verloren gehen, sollten die Prozesssignale entsprechend hochfrequent aufgezeichnet werden. Abtastraten von mehr als 100kHz sind durchaus notwendig.

Speicherplatz und Bandbreite

Aus Sicht der Steuerungstechnik führen diese Anforderungen zu zwei wesentlichen Herausforderungen. Zum einen wird viel Speicherplatz und zum anderen hohe Bandbreiten bei der Übertragung benötigt. Einzelne lokale Festplatten reichen nicht aus, um alle wesentlichen Prozessinformationen zu speichern. Kann dann z.B. Abhilfe über eine cloudbasierte Architektur mit einem skalierbaren Datenspeicher geschaffen werden, muss als Nächstes eine Datenübertragung von der Datenquelle zum Cloudspeicher erfolgen. In der Steuerungstechnik sind übliche Kommunikationsprotokolle wie Feldbusse oder OPC UA allerdings nicht für zyklische Übertragungsraten von 100kHz oder mehr ausgelegt. Aus diesem Grund muss eine Architektur gewählt werden, welche die Daten lokal erfasst und komprimiert, bevor sie an die Cloud übertragen werden können.

Kompression von Prozessdaten

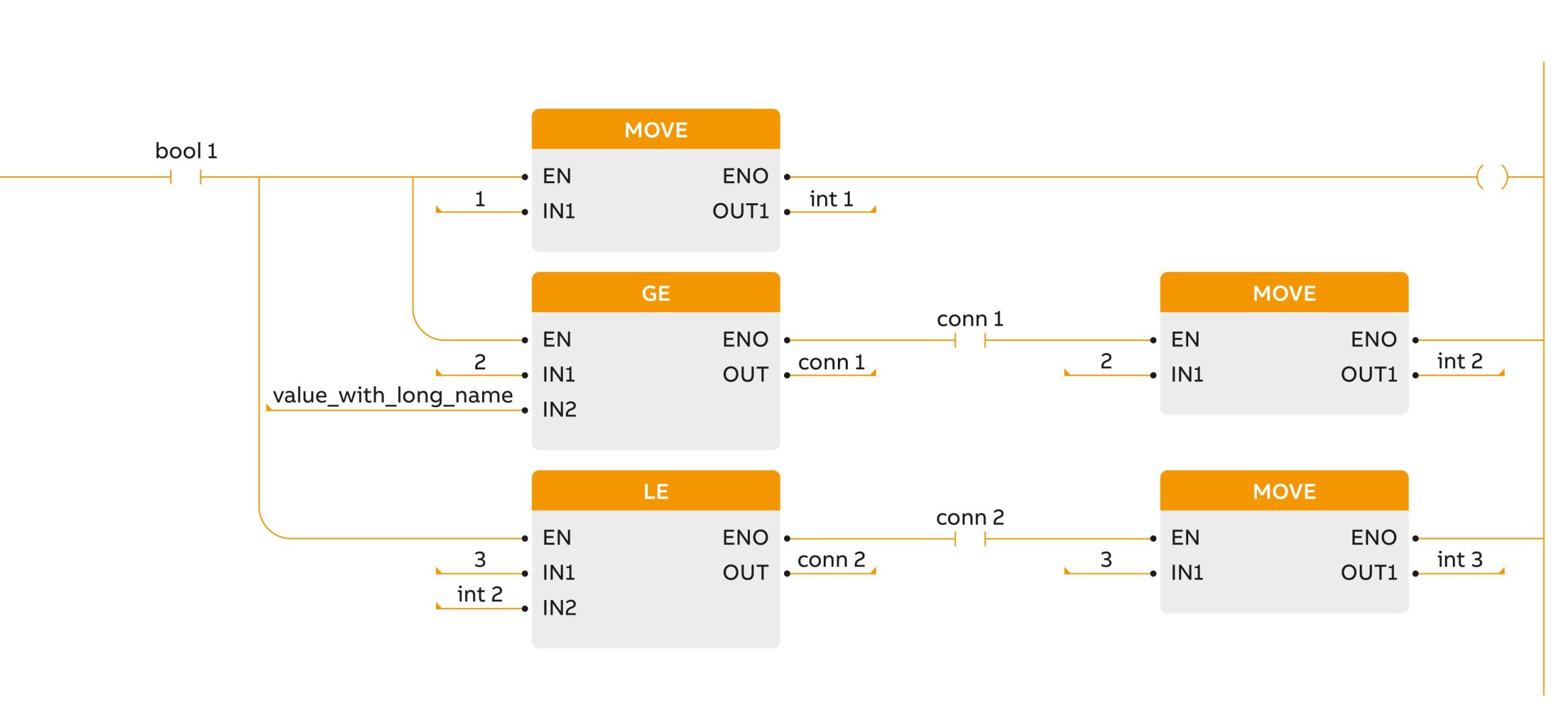

Im Falle der Prozessdaten gibt es grundsätzlich zwei Herangehensweisen zur Datenreduktion. Die erste Möglichkeit ist die verlustfreie Kompression. Dazu zählen Algorithmen, die aus den komprimierten Dateien wieder die Originaldateien herstellen können. Bekannte Kompressionsmethoden dieser Art basieren etwa auf der Wörterbuchmethode. Deutliche höhere Komprimierungsraten können durch eine Reduzierung des Informationsgehaltes, sprich Informationsverlust, erreicht werden. Bei dieser zweiten Möglichkeit zur Datenreduktion wird von einer verlustbehafteten Kompression gesprochen. Beispiele dafür finden sich im Bereich der Bildverarbeitung oder der Audioverarbeitung. Diese Methoden lassen sich jedoch auch auf die Erfassung von Prozesssignalen beim Lichtbogenschweißen übertragen, wie das folgende Beispiels mit Zahlen zeigt.

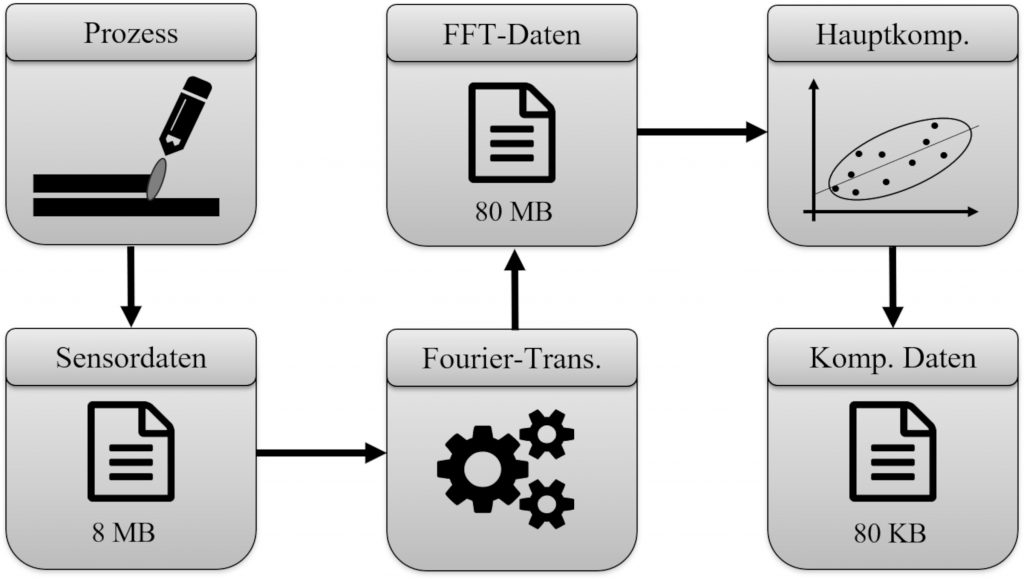

8MB Rohdaten pro Sekunde

Ein Sensor misst kontinuierlich eine Prozessgröße über die Zeit mit einer Abtastrate von 1.000.000 Werten pro Sekunde. Wenn jeder Wert mit einer Genauigkeit von 64 Bit bzw. 8 Byte gespeichert wird, entstehen pro Sekunde Rohdaten von 8MB. Eine Möglichkeit diese Daten zu komprimieren liegt in der Kombination aus einer schnellen Fourier-Transformation mit anschließender Hauptkomponentenanalyse. Dabei werden die Zeitsignale zunächst in den Frequenzbereich überführt. Bei einer schnellen Fourier-Transformation mit rollender Fensterfunktion und einer Überabtastung von Faktor 10, vergrößert sich die Dateigröße der Rohdaten von 8 auf 80MB. Allerdings werden die einzelnen Frequenzen dafür in einem Bereich von 0 bis 500kHz mit einer Auflösung von 0,1kHz angezeigt. Folglich ergibt das 5.000 Werte. Im zweiten Schritt erfolgt eine Dimensionsreduktion mittels Hauptkomponentenanalyse. Bei dieser werden die abzubildenden Signale durch eine Kombination aus Basisfunktionen, auch Hauptkomponenten genannt, dargestellt. Der Vorteil hierbei ist, dass die Basisfunktionen nur ein einziges Mal abgespeichert werden müssen. Für das Abspeichern der Zeitsignale reicht es aus, den Faktor jeder Hauptkomponente zu speichern. Bei Untersuchungsreihen mit Prozesssignalen beim Lichtbogenschweißen konnte gezeigt werden, dass bereits fünf Hauptkomponenten ausreichen, um 99 Prozent der enthaltenen Information zu speichern. Die 5.000 Werte des Signals im Frequenzbereich reduzieren sich somit auf fünf Werte. Die ursprünglich 8MB große Datei wird zunächst in einem Zwischenschritt auf 80MB vergrößert und in einem zweiten Schritt dann auf 80KB reduziert.

Von der Datenkompression zum überwachten Lernen

Eine Datenkompression mit solch hoher Kompressionsrate ermöglicht es, sehr hochauflösende Prozessdaten kontinuierlich aufzuzeichnen und in einem zentralen Datenspeicher abzulegen. Werden diese Daten zusätzlich mit weiteren Informationen über die Konfiguration des Schweißprozesses und mit einer Qualitätsbewertung ergänzt, ergibt sich ein vollständiger Datensatz, welcher anschließend für überwachtes Lernen verwendet werden kann. Das bedeutet, dass ein Modell trainiert wird, welches Muster in den Prozessdaten erkennt und diese der Qualitätsinformation zuordnet. Nachdem dieses vorliegt, kann es im Folgenden zur Prozessüberwachung oder Qualitätsprüfung eingesetzt werden. Mehr zu diesem Thema erfahren Sie auf den Stuttgarter Innovationstagen im März 2021. n Stuttgarter Innovationstage 2021

Steuerungstechnik aus der Cloud? Der einst kontrovers diskutierte Ansatz wurde vor fünf Jahren erstmals umfangreich auf der Fachtagung Stuttgarter Innovationstage präsentiert. Zum fünfjährigen Jubiläum werden Experten und Anwender am 2. und 3. März 2021 in einer Podiumsdiskussion die Fortschritte der Steuerungstechnik aus der Cloud und reale Anwendungsfälle aufzeigen. Zusätzlich geben an beiden Tagen die Schwerpunktthemen Software Defined Manufacuturing und Intelligente Produktion Einblicke in aktuelle Trends und Entwicklungen. Die Fachvorträge und der direkte Kontakt zu den geladenen Experten aus den Fachbereichen der IT und Automatisierungstechnik ermöglichen den interdisziplinären Austausch mit den Gestaltern der Steuerungstechnik von morgen. Weitere Infos zur Fachtagung unter www.stuttgarter-innovationstage.de