Die meisten IT-Experten sagen Cloud Computing eine große Zukunft voraus – auch in der Automatisierungsbranche. Schaut man sich den Markt aber genauer an, so findet man im Automatisierungsumfeld aktuell noch sehr wenige \’echte\‘ Cloud-Lösungen. \’Echte\‘ Cloud-Lösungen bauen auf Public Platform-as-a-Service (PaaS)-Angeboten auf und sind mandantentauglich. Letztere zeichnen sich durch eine zwischen den Kunden geteilte Infrastruktur und Anwendungslogik aus, bei denen eine isolierte Datenhaltung und -verarbeitung erfolgt. Gerade bei kleineren und mittleren Unternehmen (KMU) überwiegt noch die Skepsis gegenüber dem Cloud-Ansatz. Dabei gibt es genügend potenzielle Anwendungsszenarien, die für eine Cloud-basierende Softwarelösung prädestiniert sind.

Potenzielle Kandidaten für die Cloud

Im industriellen Umfeld gibt es zahlreiche Anwendungsfelder, in denen Cloud-Lösungen ihre Vorteile ausspielen und einen Mehrwert bieten.

- Ein Werkzeugmaschinenbauer möchte beispielsweise permanent Leistungs- und Verschleißdaten seiner weltweit installierten Maschinen überwachen und sie an zentraler Stelle zusammenführen. Durch die systematische Auswertung der Daten, hofft er seinen Kunden die höchstmögliche Verfügbarkeit seiner Werkzeugmaschinen garantieren zur können. Ferner möchte der Maschinenbauer aus den global gesammelten Daten neue Erkenntnisse für zukünftige Produktentwicklungen ableiten.

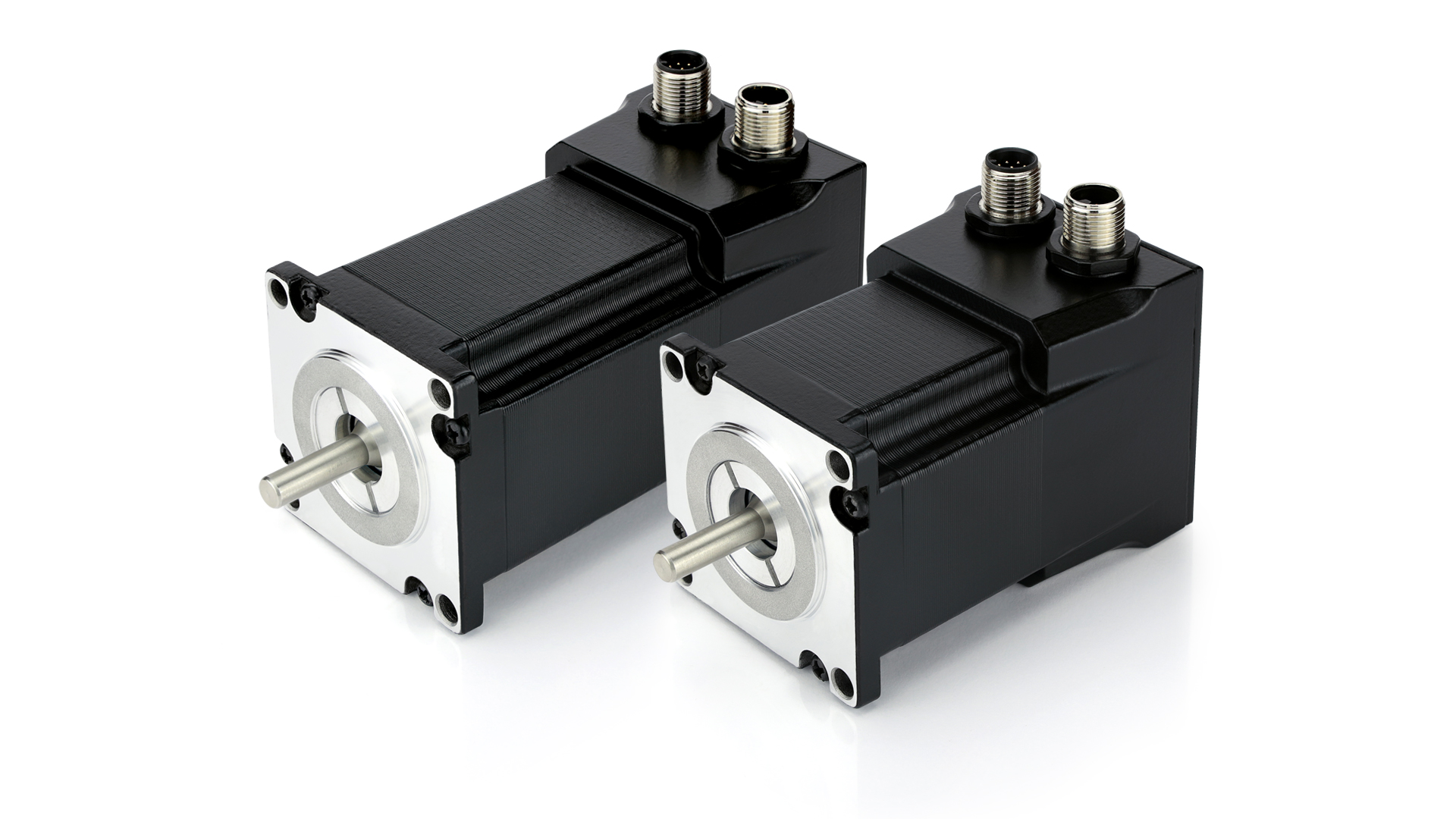

- Ähnliche Ziele verfolgt ein Hersteller von Feldgeräten. Um eine globale Zustandsüberwachung der ausgelieferten Geräte anbieten zu können, möchte er die kontinuierlich anfallenden Daten der Geräte zentral aufbewahrt wissen. Um seinen Kunden zusätzlich noch einen Mehrwert bieten zu können, möchte er die Ergebnisse der Zustandsüberwachung auch direkt für die Wartungsplanung online und plattformunabhängig zur Verfügung stellen.

- Die Verfahrenstechniker eines global agierenden Produktionsunternehmens möchten an weltweit verteilten Produktionsstandorten für bestimmte Prozessschritte systematisch Daten erfassen, um sie später mittels Data Mining auf bisher noch unbekannte systematische Zusammenhänge zu untersuchen und daraus Prozessverbesserungen abzuleiten.

- Der Betreiber eines kleinen Produktionsbetriebs möchte die Zustände der verschiedenen Produktionsanlagen seiner Fabrik überwachen können – auch wenn er unterwegs ist. Bei besonders kritischen Situationen möchte er zusätzlich per Mitteilung auf seinem Smartphone gewarnt werden und den Zustand seiner Anlage mobil einsehen können.

- In einem landesweiten Programm zur Verbesserung von Umweltstandards sollen abertausende von Messstellen eingerichtet werden, die systematisch Messdaten zur Luft- oder Gewässerverschmutzung sammeln und für eine permanente Überwachung an ein zentrale Leitstelle senden.

Warum eignet sich die Cloud?

All diese Szenarien sind sehr verschieden, aber ihre grundsätzlichen Anforderungen sind nicht neu und überschneiden sich in vielen Bereichen:

Große Datenmengen müssen permanent gesammelt und zuverlässig wie auch ausfallsicher an einer zentralen Stelle gespeichert werden, damit übergreifende Auswertungen möglich sind. Die Spannbreite der zu sammelnden Datenmenge beginnt bei einigen Megabytes, kann aber durchaus weit in den Terrabyte-Bereich gehen. Damit sind gängige relationale Datenbanksysteme schnell überfordert oder benötigen massive Hardwareressourcen – was gerade KMUs den Einstieg erschwert. Cloud-Lösungen setzen an diesem Punkt an und bieten Ressourcen, die im Vergleich zu klassischen in-house-Lösungen in der Cloud flexibel bei Bedarf bereitgestellt, betrieben und abgerechnet werden können.

Für ein effizientes Monitoring müssen die Daten in geeigneter Weise visualisiert werden. Am einfachsten geht dies heute mit browserbasierten Lösungen, welche mit HTML5 entwickelt und anschließend auch für mobile Geräte bereitgestellt werden können. Ein echter Mehrwert wird dabei in Kombination mit mobilen Cloud-Diensten erreicht. Grund hierfür sind Cross-Plattform-Dienste die einheitliche Schnittstellen zu den verschiedenen Geräte-Plattformen (iOS, Android, etc.) bereitstellen, z.B. für Push-Benachrichtigungen oder Dienste die gängige Probleme wie beispielsweise Synchronisation von Offlinedaten lösen.

Mit den Rohdaten, die beispielsweise beim Monitoring anfallen, kann alleine meist nicht viel angefangen werden. Daher müssen die Daten parallel zum Monitoring in Echtzeit nach bestimmten Kriterien untersucht, verdichtet und darauf aufbauend aussagefähige Key-Performance-Indikatoren (KPIs) berechnet werden. Anhand dieser können dann automatische Maßnahmen oder Benachrichtigungen abgeleitet werden. Entsprechende Lösungen sind komplex und aufwendig aufzubauen. Aus diesem Grund bieten Cloud-Anbieter vorkonfigurierte Dienste an, die mit den vorhandenen Daten verknüpft werden können. Die bereitgestellten Dienste setzen meist auf rechenintensive Technologien wie Echtzeitdatenstromanalyse (Complex Event Processing) oder Machine Learning. Die hierfür notwendige Rechenleistung wird größtenteils nur für verhältnismäßig kurze Zeiträume benötigt – eine Eigenschaft, an der die Anbieter ansetzen. Sie stellen eine Hochleistungsinfrastruktur auf Basis von Commodity-Hardware (günstiger, weitverbreiteter und einfach zu ersetzender Standardhardware) mehreren Kunden dynamisch zur Verfügung, geben Kostenvorteile an diese weiter und machen dadurch die Technologien auch Unternehmen zugänglich, denen diese bisher aus Kostengründen verwehrt blieben.

Aus der Analyse der historischen Massendaten können wichtige Erkenntnisse gezogen werden. Hierfür gewinnen neue Verfahren aus dem Bereich \’Big Data\‘ zunehmend an Bedeutung. Neben kurzzeitiger Rechenleistung wird beachtlicher Speicherplatz zur Archivierung der Daten benötigt. Gerade wenn es in diesem Bereich um In-Memory-Technologien oder Hadoop Cluster geht, sind die meisten Unternehmen den Anforderungen an die Infrastruktur nicht gewachsen.

Betrachtet man die Vielzahl der vorhandenen Geräte (Sensoren, Steuerungen, etc.), welche in kurzen Intervallen Daten senden können, kommt man mit herkömmlichen Systemen schnell an die Grenzen. Abhilfe bieten Cloud-Anbieter mit sogenannten \’Internet of Things\‘-Infrastrukturen. Hierbei handelt es sich um hochverfügbare, skalierbare und sichere Plattformen, die Daten von Millionen von Geräten entgegen nehmen und verarbeiten können. Die Anbindung der Geräte an die bereitgestellten Dienste ist dabei äußerst einfach, da Cloud-Dienste in der Regel eine Rest-Schnittstelle anbieten. Rest-Dienste basieren auf dem HTTP-Protokoll und können quasi in jeder Umgebung und Programmiersprache – auch über Firewall-Grenzen hinweg – angesprochen werden. Zudem bieten die Anbieter meist zusätzliche Frameworks für Embedded Devices, welche eine einfache Anbindung an die Cloud ermöglichen (z.B. Microsoft mit dem .Net Micro Framework).

Weit verteilte Datenquellen, große Datenmengen, hoher oder dynamischer Datendurchsatz, sporadisch erhöhter Bedarf an Rechenkapazität für ressourcenhungrige Berechnungen, weltweite Verfügbarkeit der Ergebnisse: All dies sind klare Indikatoren, dass Anwendungen ideale Kandidaten für eine Cloud-Lösung sind.

Datensicherheit ist derzeit ein zentrales Thema

Die gesammelten Daten sind meist sehr sensibel und müssen vor unbefugtem Zugriff wirksam geschützt werden. Das führt zu der reflexhaften Annahme, dass diese Daten auf keinen Fall das lokale Intranet verlassen dürfen und eine Ablage und Verarbeitung in der Public Cloud auf keinen Fall in Frage kommt. Schon gar nicht, wenn es sich um eine Cloud-Lösung handelt, die auf einer der großen Plattformen wie Microsoft Azure oder Amazon Web Services betrieben wird. Grundsätzlich hat eine cloud-basierte Lösung jedoch nicht mehr Risiken wie eine Lösung die in-house betrieben wird. Der Datenzugriff von jedem Ort der Welt bringt eine neue Angriffsfläche für jede Art von Anwendung mit sich. Diese ist jedoch aufgrund der Anforderungen unumgänglich. Die Autoren sind der Meinung, gerade weil die Datensicherheit so wichtig ist, ist es besser sie einem hoch professionellen Betreiber von großen Datenzentren zu überlassen anstelle der eigenen, womöglich personell unterbesetzten IT-Abteilung oder – noch schlimmer – eine sogenannten Schatten-IT in der Eigenregie der Produktion- oder Entwicklungsabteilung.

Bei der Auswahl und Beurteilung von Cloud-Anbietern helfen Zertifikate wie ISO27001, SAS70/SSAE 16, FISMA, HISPAA oder ähnliche, die als Prüfsiegel für IT-Sicherheit und Compliance anerkannt sind. Diese werden in der Regel durch unabhängige Prüfstellen ausgehändigt und regelmäßig überprüft. Die Ergebnisse der Prüfungen werden in einem Prüfbericht veröffentlich und damit jedem zugänglich gemacht. Zur Erfüllung der strengen Anforderungen setzt der Cloud-Anbieter Microsoft beispielsweise eine tiefgehende Sicherheits-Strategie (Defense-in-Depth Strategie) ein. Diese besteht aus einer Reihe von technischen und organisatorischen Maßnahmen sowie einem weitreichenden internen Kontrollsystem zur Prüfung der Einhaltung. Die Defense-in-Depth-Strategie deckt alle Bereiche, beginnend bei Datensicherheit, Anwendungs- und Hostüberwachung bis hin zu physischen Sicherheitsmaßnahmen ab. Die Cloud-Anbieter sind permanent bestrebt den Anforderungen/Sicherheitsbedenken gerecht zu werden. Schließlich herrscht im Industriebereich ein hohes Geschäftspotenzial. Lösungen, die auf den großen Plattformen aufbauen, können schon heute einen hohen Sicherheitsstandard erreichen. Ein vergleichbarer Sicherheitslevel kann gerade von KMUs bei einer in-house betriebenen Infrastruktur kaum erreicht werden. Nicht nur der Aufwand und die Kosten für die Anschaffung und den Betrieb, sondern auch der notwendige Know-how-Aufbau sind schlichtweg zu hoch. Interessanterweise ist dennoch die Akzeptanz von Cloud Computing bei sehr großen Unternehmen breiter als bei KMUs, obwohl diese doch eigentlich von den Vorteilen viel stärker profitieren könnten. So zeigen verschiedene Umfragen, wie die aktuelle Studie \’Cloud Monitor 2014\‘ der KPMG in Zusammenarbeit mit der Bitkom, dass Cloud Computing bei Großunternehmen quasi schon heute zum Standard gehört, jedoch die Bedeutung bei kleinen Unternehmen vergleichsweise gering ist.

Es gibt Beratungsbedarf

Software-as-a-Service (SaaS) Angebote, basierend auf Public-Cloud-Infrastrukturen, werden sich mittelfristig in großer Breite durchsetzen. Die Meinung zahlreicher IT-Experten zeigt, dass die Zeit für Cloud Computing arbeitet und immer mehr IT-Verantwortliche sich dem Thema widmen. Natürlich sollte der Schritt in die Cloud und zu einem neuen Vertriebs- und Geschäftsmodell für Softwarelösungen dabei nicht blauäugig oder überstürzt erfolgen, schon gar nicht unter dem Eindruck der zahlreichen und aktuellen Datenschutzskandale. Bezüglich der Aufklärung über Auswirkungen von Cloud Computing auf Softwareanbieter, sieht M&M Software neben organisatorischen und rechtlichen Aspekten auch bei technischen und wirtschaftlichen Gesichtspunkten erheblichen Nachholbedarf – sowohl in der Automatisierungsbranche als auch im Maschinen- und Anlagenbau. Um den Kunden eine kompetente Anlaufstelle für Antworten rund um das Thema Cloud Computing zu bieten, hat sich das global agierende Technologie- und Beratungsunternehmen auf dieses Thema spezialisiert. Das Dienstleistungsangebot reicht von der Unterstützung bei der Visionsfindung, bis hin zur Anforderungsanalyse und Lösungsplanung. Des Weiteren hilft M&M in den weiteren Schritten der Produktumsetzung – sei es eine Neuentwicklung oder die Migration einer bestehenden Anwendung in die Cloud.