Um sowohl die Vorteile als auch die Herausforderungen des Einsatzes von Echtzeit-Bilderfassung in einem industriellen Kontext zu verstehen, schauen wir uns VHIT an, eine Geschäftseinheit, die vor kurzem aus Bosch ausgegliedert wurde und Schmier- und Vakuumpumpen für Elektro-, Benzin- und Dieselfahrzeuge herstellt.

VHIT versendet jährlich etwa 6 Millionen Pumpen. In der Vergangenheit führte ein Arbeiter die visuelle Kontrolle der Filter durch. Die Einführung eines Kamerasystems konnte die Ausschussquote zwar verringern, doch verzeichnete das Unternehmen immer noch eine Falsch-Positiv-Rate (das heißt Filter, die als fehlerhaft eingestuft wurden, obwohl sie vollkommen in Ordnung waren) von 2,3% (138 Tausend Stück). Das Bildverarbeitungssystem wurde dann um KI erweitert, wobei eine aktualisierbare Datenbank mit Bildern von Gut- und Schlechtteilen verwendet wurde, um ein Inferenzmodell für die Entscheidungsfindung in der Fabrik zu erstellen. Dieser Ansatz konnte die Quote der falsch positiven Ergebnisse auf 0,2% senken.

Das Programm erfasst Daten von Kameras in Produktionsanlagen und Logistiklagern und nutzt Algorithmen des maschinellen Lernens, um Qualitätsprobleme zu erkennen und Informationen in das Manufacturing Execution System (MES) einzuspeisen, um in Echtzeit eine optimale Entscheidung zu treffen. Wenn das System sicher mit der Cloud verbunden ist, profitiert es vom kontinuierlichen Zugriff auf fortschrittliche Algorithmen der künstlichen Intelligenz und Datenanalysepakete. Das entscheidende Wort in diesem Satz ist eindeutig ’sicher‘. Da diese Systeme für den Fertigungsprozess von entscheidender Bedeutung sind, müssen sie gegen Hackerangriffe und Fehlfunktionen eines anderen Programms, das auf derselben Hardware läuft, geschützt werden. Wie lässt sich dies erreichen?

Der aktuelle Sicherheitskontext

Die Virtualisierungstechnologie, bei der mehrere Betriebssysteme auf gemeinsam genutzter Hardware ausgeführt werden können, ist wohlbekannt und sehr gut verstanden, auch wenn sie etwas ineffizient in der Nutzung der Ressourcen ist. Noch vor wenigen Jahrzehnten verwendete jeder virtuelle Maschinen (VM), um die Infrastruktur zu hosten und zu verwalten. In jüngster Zeit haben sich die Branchen auf die Verwendung von Containern mit Systemen wie Docker und Kubernetes verlagert.

Das ursprüngliche System der Virtualisierungsarchitektur basierte auf der Implementierung einer Reihe von VMs. Jede virtuelle Maschine muss ihre eigene Instanz eines Betriebssystems ausführen, was zu einer Verdoppelung der Verantwortung führt. Außerdem ist es schwierig, eine solche Infrastruktur zu verwalten, da es mehrere Server gibt, die alle unabhängige virtuelle Maschinen sind.

Container versuchen, das gleiche Konzept wie virtuelle Maschinen zu erreichen, vermeiden aber doppelten Aufwand zwischen Maschinen. Anstatt ein komplettes Betriebssystem für eine Anwendung zu laden, können Docker-Container den Kernel des Host-Betriebssystems verwenden und gleichzeitig anwendungsspezifische Bibliotheken und Programme nachladen. Durch die Anpassung des Containers und seines Images ist es möglich, die spezifischen Bibliotheken und die Konfiguration, die Ihre Anwendung verwenden wird, fein abzustimmen. Dies führt zu Leistungssteigerungen ohne den Overhead eines kompletten Betriebssystems.

Eine moderne Anwendung besteht aus vielen Containern. Sie in der Produktion zu betreiben, ist die Aufgabe von Kubernetes. Da Container leicht zu replizieren sind, können Anwendungen automatisch skaliert werden: Die Verarbeitungskapazitäten werden entsprechend den Anforderungen der Benutzer erweitert oder verringert.

Eine der Herausforderungen bei Containern ist die Sicherheit. Sie müssen mit einem Zero-Trust-Ansatz effektiv nutzbar gemacht werden. Folglich erfordert ihr Einsatz in unternehmenskritischen Umgebungen einen ‚Least Privilege‘-Ansatz, bei dem den Anwendungen nur ein Minimum an Systemressourcen zur Verfügung gestellt wird, die für die Ausführung ihrer Aufgabe erforderlich sind, sowie eine starke Isolierung zwischen den Anwendungen, damit die Betriebs- oder Anlagenleiter darauf vertrauen können, dass die Lösung die OT-Anforderungen an Sicherheit, Verfügbarkeit und Leistung erfüllt.

Einführung von Google Anthos

Jüngst wurde angekündigt, dass die Plattform Lynx Mosca.ic die Bereitstellung von Google Anthos Bare Metal unterstützt. Dies schafft eine Lösung, die es ermöglicht, jeden containerisierten Dienst an den aufgabenkritischen ‚Rand‘ zu bringen, ohne die Sicherheit oder Leistung zu beeinträchtigen.

So können jetzt z.B. Software-Dienste aus der Cloud wie der ‚Google Cloud Visual Inspection AI Service‘ implementiert werden, um eine validierte Lösung für eine sichere, videobasierte Qualitätsprüfung in Industrie- und Energieanlagen zu bieten.

Der Einsatz von Google Anthos Bare Metal bedeutet, dass jetzt ein ganzer Kubernetes-Cluster lokal auf nur einem Hardwaresystem am Rande ausgeführt werden kann – mit Kubernetes- und Workload-Management in Unternehmensqualität, vollständig verwaltetem Service-Mesh mit integrierter Transparenz und einer konsistenten Entwicklungs- und Betriebserfahrung für On-Premise- und On-Cloud-Bereitstellungen. Lynx ermöglichte eine virtuelle Luftlochspaltung, die für eine Isolierung zwischen den verschiedenen Teilen des Systems sorgt.

In der Vergangenheit stellte die Verschmelzung der Welten der Betriebstechnologie (OT) und der IT – das Trainieren von KI- und maschinellen Lernmodellen in der Cloud und die Bereitstellung von Cloud-basierten Workloads am Netzwerkrand – eine Herausforderung für die Sicherheit in unternehmenskritischen industriellen Umgebungen dar. Lynx stellt sicher, dass die drei Funktionen – Bild-erfassung (Kamera), Einblicke über die Inferenzmaschine (Google Anthos) und die Aktion mit einem übergeordneten Controller – vollständig in einer Sandbox untergebracht sind, mit der Möglichkeit, sichere Einwegverbindungen (Datendiode) zwischen ihnen herzustellen.

Bei der visuellen Inspektion (VI) könnte die Modellerstellung ein On-Cloud-Dienst sein. Vorklassifizierte Daten würden vor Ort generiert und an den VI-Modellerstellungsdienst in der Cloud weitergeleitet. Alternativ könnte auch ein hybrider Cloud-Dienst eingesetzt werden, bei dem das in der Cloud generierte VI-Modell in einer lokalen Google-Anthos-Umgebung eingesetzt wird, um die Bildinferenzierung am der Edge durchzuführen. Es besteht auch die Möglichkeit einer reinen Vor-Ort-Lösung, bei der sowohl die VI-Modellgenerierung als auch die Bildinferenzdienste vor Ort bereitgestellt werden.

Google Anthos-Bereitstellungsmodell

Die Lösung nutzt Google Anthos als verwaltete Anwendungsplattform, die es Unternehmen ermöglicht, Kubernetes und die damit verbundenen Workloads über mehrere öffentliche Clouds, Hybrid-Clouds und On-Premise-Compute-Cluster hinweg auszuführen. Wie sieht der Einsatz dieser Plattform am unternehmenskritischen Randbereich aus? Zu den primären Bausteinen einer typischen einsatzkritischen Edge-Bereitstellung gehören:

- Plattformsoftware: wird auf den Zielsystemen (oder -knoten) bereitgestellt und ermöglicht das Hosten mehrerer Arbeitslasten auf den Zielsystemen;

- Controller-Software: wird (meist) vor Ort eingesetzt, um verschiedene Knotenpunkte zu verwalten;

- Anwendungs-Framework: sorgt für eine einheitliche Kontrollebene für Endbenutzer-Workloads (entweder als eigenständige Anwendungen oder als Container);

- Workloads: Software, die Endnutzer auf dem oben genannten Anwendungsrahmen einsetzen.

Anthos-Cluster auf Bare Metal unterstützen drei Bereitstellungsmodelle, um unterschiedlichen Anforderungen gerecht zu werden: Standalone-Cluster-Einsatz, Multi-Cluster-Einsatz und Hybrid-Cluster-Einsatz. Obwohl alle drei Bereitstellungsmodelle von Google Anthos für den unternehmenskritischen Bereich relevant sind, konzentrieren wir uns hier auf die eigenständige Standalone-Cluster-Bereitstellung, bei der ein einzelner Kubernetes-Cluster sowohl die Admin- als auch die Nutzer-Cluster-Funktionen unterstützt. Ein Google Anthos-Nutzer-Cluster ist ein Kubernetes-Cluster, der Nutzer-Workloads ausführt, während ein Admin-Cluster Nutzer-Cluster verwaltet.

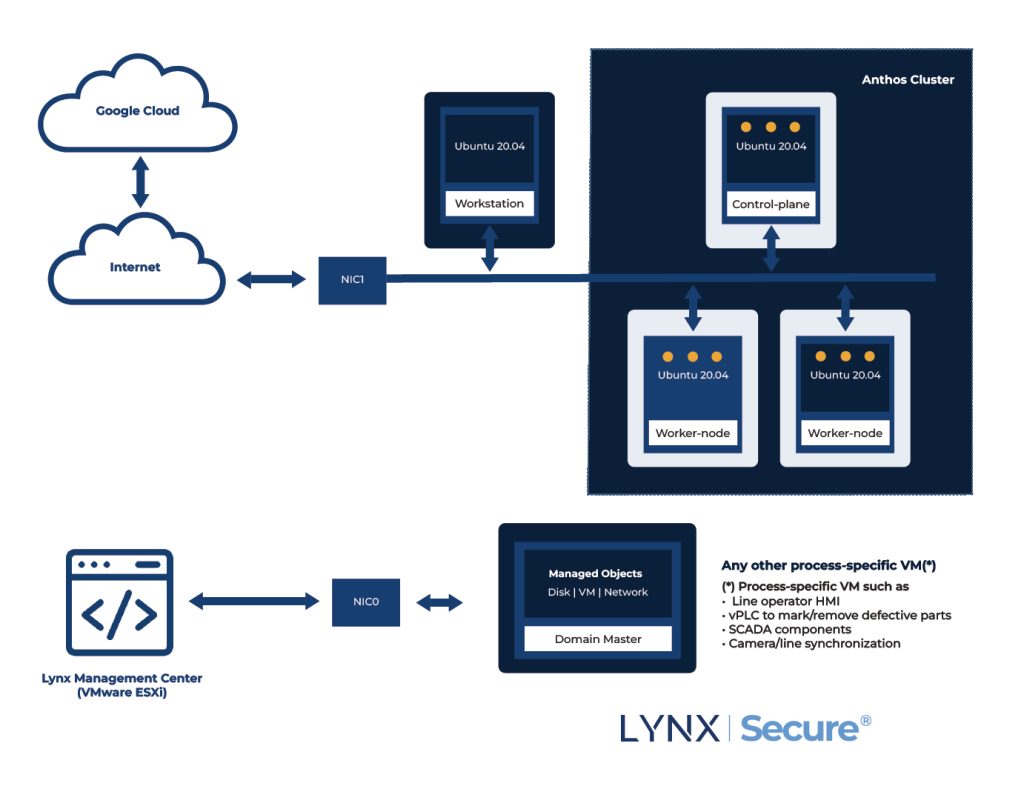

Für ein eigenständiges Bereitstellungsmodell sind sowohl die Steuerebene als auch die Arbeitsknoten erforderlich. Das Blockdiagramm auf der erstern Seite bietet einen Überblick über einen eigenständigen Google-Anthos-Cluster, der auf einem Separation Kernel Hypervisor, LynxSecure, innerhalb des Lynx Mosca.ic Software Frameworks läuft.

Fünf VMs sind für die Erledigung bestimmter Aufgaben eingerichtet:

- Vier Google Anthos-Cluster-VMs

- 1 Kubernetes-Cluster-Knoten der Steuerungsebene (als VM) – keine Unterstützung für hohe Verfügbarkeit

- 2 Worker-Kubernetes-Cluster-Knoten (als VMs) – mit Unterstützung für hohe Verfügbarkeit

- 1 Workstation-VM – wird für die Bereitstellung der Steuerebene und der Arbeitsknoten verwendet

- Eine fünfte VM für das Gerätemanagement, die die eingehenden Managementanfragen bearbeitet. In der Regel wird dies in Verbindung mit einer Verwaltungssoftware verwendet (entweder die unternehmenseigene Backend-Infrastruktur oder eine Technologie eines Drittanbieters wie ServiceNow)

Aufgrund der strikten Isolierung durch den Separation Kernel LynxSecure arbeiten die einzelnen VMs in ihren eigenen Fehlerzonen. Die Cluster-VMs (Control Plane und Worker Nodes) und die Workstation-VM sind über virtuelle Ethernet-Links (implementiert über verwalteten Shared-Memory) verbunden. Obwohl die VM, die das Gerätemanagement hostet, Zugang zum Lynx Management Center hat, hat sie keine interne Verbindung zu den Cluster-VMs. Diese Anordnung in Verbindung mit den strengen Isolationsgarantien des LynxSecure Separation Kernel Hypervisor stellt sicher, dass die Google Anthos-Workloads praktisch von den Aktivitäten der Verwaltungsebene getrennt sind.

Fazit

Für Industrie- und Energieunternehmen, die bereits unter der Belastung durch Unterbrechungen der Lieferkette, Arbeitskräftemangel und mehr leiden, können videobasierte Qualitätssysteme, die mit KI erweitert wurden, eine wichtige Rolle bei der Verbesserung der Leistung und Qualität der Produktion spielen. Wie das VHIT-Beispiel zeigt, können durch eine effiziente Sichtprüfung Fehler bis um das Zehnfache reduziert, die Auslieferung fehlerhafter Teile verhindert und Erkenntnisse über die Fehlerursache gewonnen werden, um Prozesse zu optimieren.

Doch sind die mit diesen Einsätzen verbundenen Sicherheitsrisiken real und erheblich. In der Vergangenheit stellte die Verschmelzung der Welten der Betriebstechnologie (OT) und der IT – das Trainieren von KI- und maschinellen Lernmodellen in der Cloud und die Bereitstellung von Cloud-basierten Workloads am Netzwerkrand – eine Herausforderung für die Sicherheit in unternehmenskritischen industriellen Umgebungen dar.

Wir haben dargestellt, dass es heute Technologien gibt, mit denen diese Risiken gemildert werden können und auch, dass es möglich ist, lückenlose Implementierungen zu schaffen, die die Vorteile voll ausschöpfen und gleichzeitig das Risiko von Sicherheitsverletzungen aufgrund von Softwarefehlern oder externen Angriffen minimieren.