Gesehen, gespeichert, gelernt!

Unbekannte Teile sicher greifen – Wissenschaftler des KIT zeigen, wie Roboter Bin-Picking-Aufgaben selbst trainieren können. Dabei helfen eine Ensenso 3D-Kamera von IDS und ein neuronales Netz. Details erfahren Sie in der Case Study.

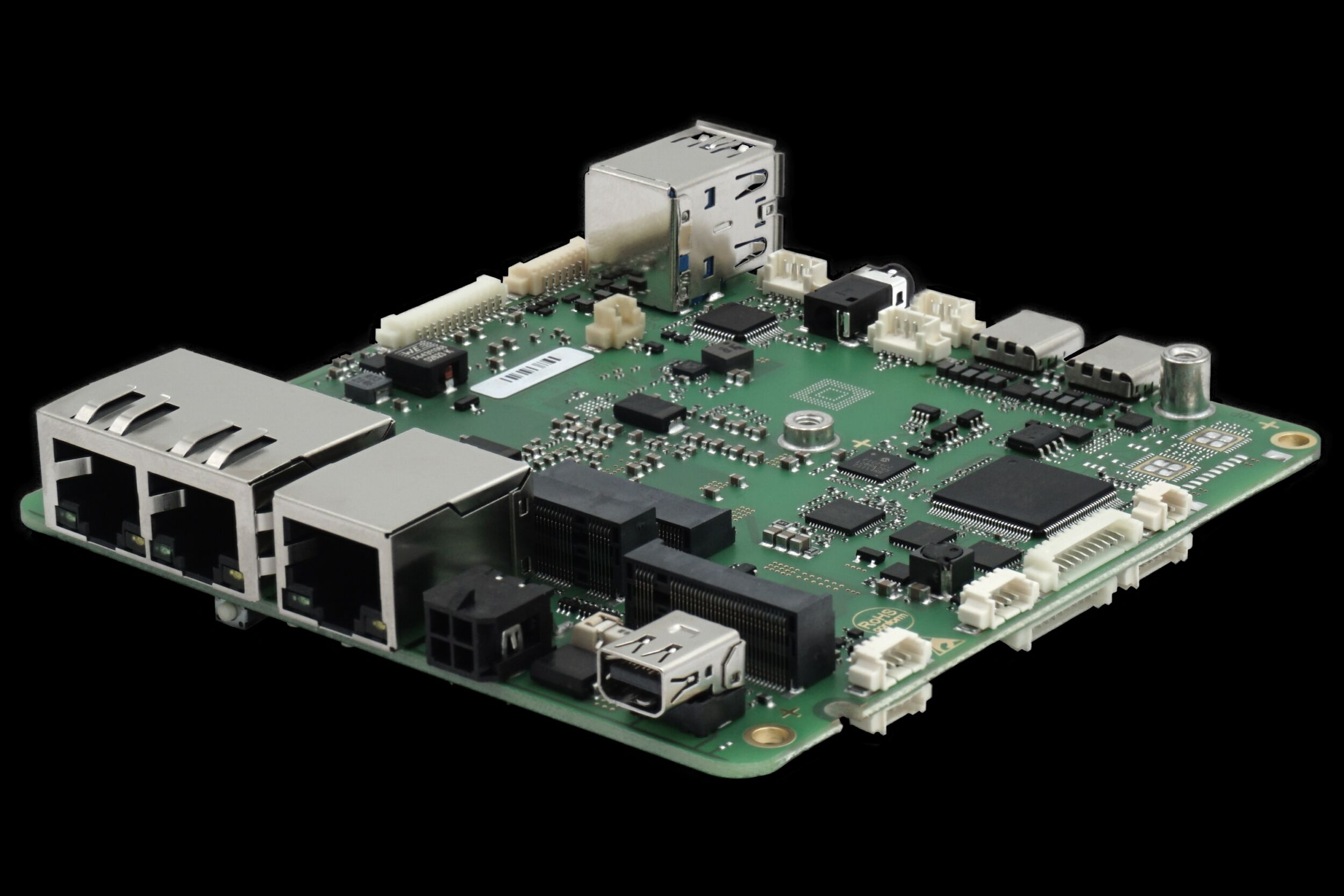

Am Institut für Intelligente Prozessautomation und Robotik des Karlsruher Instituts für Technologie (KIT) befasst sich die Robot Learning Group (ROLE) mit verschiedenen Schwerpunkten in den Bereichen des maschinellen Lernens. Dabei erforschen die Wissenschaftler, wie Roboter durch selbstständiges Ausprobieren lernen Aufgaben zu lösen. Diese Methoden werden insbesondere für das Lernen von Objektmanipulation eingesetzt, beispielsweise für das Greifen von Objekten in einem typischen Bin Picking Szenario. Eine Ensenso N10 3D-Kamera von IDS direkt am „Kopf“ des Roboters liefert die benötigten Bilddaten.

Das Greifen von chaotisch liegenden Gegenständen ist gerade in der industriellen Automation eine zentrale Aufgabe. Aktuelle Bin Picking Lösungen sind jedoch häufig unflexibel und stark an das zu greifende Werkstück angepasst. Die Forschungsprojekte der Robot Learning Group versprechen Abhilfe, z.B. mit Robotern, die selbständig lernen, zuvor unbekannte Objekte aus einem Behälter zu greifen. Um eine solche Aufgabe zu lernen, beginnt der Roboter zunächst mit zufälligen Greif-Versuchen, wie es auch ein Mensch machen würde. Ein neuronales Netz setzt die dabei aufgenommenen 3D-Bilder mit den erfolgreichen bzw. missglückten Greifversuchen in Zusammenhang. Dafür wird zu jedem Bild das Greifergebnis gespeichert, das über einen Kraftsensor im Greifer ermittelt wurde. Die KI (künstliche Intelligenz) erkennt anhand der gespeicherten Daten sinnvolle Greifpunkte für die Objekte und „trainiert“ sich damit selbst. Wie bei modernen Methoden des Reinforcement Learning üblich, sind dazu große Datenmengen und viele Greifversuche unerlässlich. Die Forscher des KITs konnten die Anzahl letzterer jedoch deutlich reduzieren und damit auch die zum Lernen benötigte Zeit verkürzen.

Die Forscher der ROLE-Gruppe nutzen das Ensenso SDK, um Tiefenbilder aufzunehmen und mit OpenCV und TensorFlow weiter zu verarbeiten (Bild: IDS Imagaging)

Die visuelle Grundlage für den Griff des Roboters liefert eine Ensenso 3D-Kamera. Sie blickt von oben auf den Behälter, zufällig gefüllt mit Objekten einer oder verschiedener Art. Das Bildverarbeitungssystem projiziert eine kontrastreiche Textur auf den Kisteninhalt und erzeugt eine 3D-Punktewolke der von oben sichtbaren Oberflächen, als Basis für die Berechnung des Tiefenbildes in Graustufen. Das Tiefenbild wird anschließend auf eine Auflösung von nur 12.000 Pixel skaliert und als Eingabe für die KI-Algorithmen verwendet. Das neuronale Netz kümmert sich daraufhin um die Bildanalyse und die folgerichtigen Schritte für den nächsten Griff in die Kiste. Die ausführliche Case Study lesen Sie auf der IDS-Website.