Der Fokus von Weidmüller liegt auch bei Machine Learning auf dem Maschinen- und Anlagenbau – damit erstreckt sich das Anwendungsgebiet aber über zahlreiche Branchen und Marktsegmente. Entsprechend reicht das Spektrum der bereits umgesetzten Referenzen von Schweißapplikationen in der Automobilindustrie über Separatoren in der Nahrungsmittelindustrie bis zu Werkzeugmaschinen.

Nur die Daten zählen

„Die Art der Maschine ist für das Industrial AutoML Tool eigentlich komplett egal“, sagt Tobias Gaukstern, VP Industrial Analytics bei Weidmüller. „Wichtig sind für uns nur die erfassten Maschinendaten bzw. Zeitreihendaten, die aus der Steuerung, der Sensorik oder der Aktorik kommen: Ströme, Spannungen, Drehmomente, Temperaturen und und und.“ Maschinenbauer und Fertigungsbetreiber stehen in der Regel vor der Herausforderung, diese Daten sinnvoll zu nutzen – etwa um Unregelmäßigkeiten oder Störungen vorherzusehen oder auch die Qualität der gefertigten Produkte in Echtzeit sicherzustellen bzw. zu dokumentieren. Mit solchen Analysemethoden lassen sich also nicht nur Stillstände vermeiden, sondern auch deutlich aufwändigere Prüfmethoden im Produktionsprozess. „Soll eine smarte Analytics-Lösung umgesetzt werden, musste bisher ein komplexer Prozess durchlaufen werden“, betont Gaukstern. Daten müssen aufbereitet und die passenden Methoden und Verfahren gewählt werden. „Es gibt eine große Vielfalt an Machine-Learning-Verfahren“. Und das ist nur der Anfang. Es warten zahlreiche weitere Fragen auf den Anwender: Passt das Verfahren zum Use Case und zur Datenlage? Welcher Teil des Datensatzes spiegelt das Normalverhalten wieder? Reichen die Rohdaten überhaupt aus? Welche Features sollten genutzt werden, um ein gutes ML-Modell zu trainieren? Solchen Fragen sind im Zuge einer Machine-Learning-Anwendung zu beantworten – normalerweise unter Zuhilfenahme von Data-Scientists. „Doch alleine können sie die Anwendung nicht umsetzen“, fährt Gaukstern fort. „Die identifizeirten mathematischen Zusammenhänge in den Daten sind immer auch ingenieursmäßig zu interpretieren.“

Domänenwissen entscheidet

Ergo: Für erfolgreiches maschinelles Lernen sind also auch Leute erforderlich, die auf Seite der Produktionsprozesse ausreichend Expertise und Erfahrung einbringen können. „Beide Personengruppen müssen zusammenarbeiten“, erklärt Gaukstern und ergänzt augenzwinkernd: „Oder etwa doch nicht?“ Denn Weidmüller hat sich das Ziel gesetzt, Machine Learning so weit zu vereinfachen, dass der Maschinenexperte diese Aufgabe alleine lösen kann. „Im ersten Schritt kaum vorstellbar“, so Gaukstern. Schließlich gebe es 1.040 Kombinationsmöglichkeiten, um eine Machine-Learning-Pipeline zu erstellen. Doch gerade diese Komplexität spreche dafür, den Prozess zu automatisieren. Nur so lasse sich Machine Learning auch in der industriellen Breite anwenden. „Es gibt letztlich viel zu wenig Data-Scientists“, unterstreicht Gaukstern, „die Domänenexperten sind hingegen viel zahlreicher und ihr Applikationswissen ist ohnehin notwendig, um eine ML-Lösung zu erarbeiten.“ Diese Erkenntnis hat Weidmüller zur Vision gebracht: „Wir wollen Machine Learning so vereinfachen, so dass Domänenexperten eigenständig Lösungen entwickeln und ihr Anwendungswissen in Mehrwert überführen können – ohne das Data Science Expertise notwendig ist“, bringt es Gaukstern auf den Punkt. Dafür hat das Unternehmen die Industrial AutoML Software geschaffen“Den technologischen Ansatz dahinter nennen wir Automated Machine Learning – kurz AutoML.“ Ganz automatisch läuft der Prozess aber nicht ab. „Wir haben uns entschlossen, an dedizierten Stellen das Wissen der Experten abzufragen und sie somit durch die Modellbildung und das Training zu führen.“

In vier Schritten zum passenden Modell

Den Prozess hat Weidmüller in vier Hauptschritte unterteilt. Damit gelinge Machine Learning sehr schnell „Mit dem AutoML Toll sind Ingenieure in der Lage einen Proof-of-Concept in nur rund einer Stunde umzusetzen“, versichert Tobias Gaukstern. „Ein Data Scientist braucht dafür schon mal 20 Tage oder mehr.“ Das allein zeige, welches Potenzial AutoML mitbringe. Für die gesamte Entwicklung einer Machine-Learning-Anwendung stellt der Anbieter eine Zeitersparnis von bis zu 80 Prozent in Aussicht. Durch den No-code-Ansatz muss dabei nichts programmiert werden. „Und auch sonst haben wir die Komplexität weitgehend verborgen“, erklärt Gaukstern. „Von den 1.040 Optionen bei der Modellbildung kriegt der Anwender eigentlich gar nichts mit.“ Stattdessen soll sich der Nutzer darauf konzentrieren sein spezielles Prozess- bzw. Domänenwissen einzubringen. Insgesamt sind nur vier Schritte zu durchlaufen, um ein erstes ML-Modell zu trainieren.

Datenanreicherung mit Domänenwissen

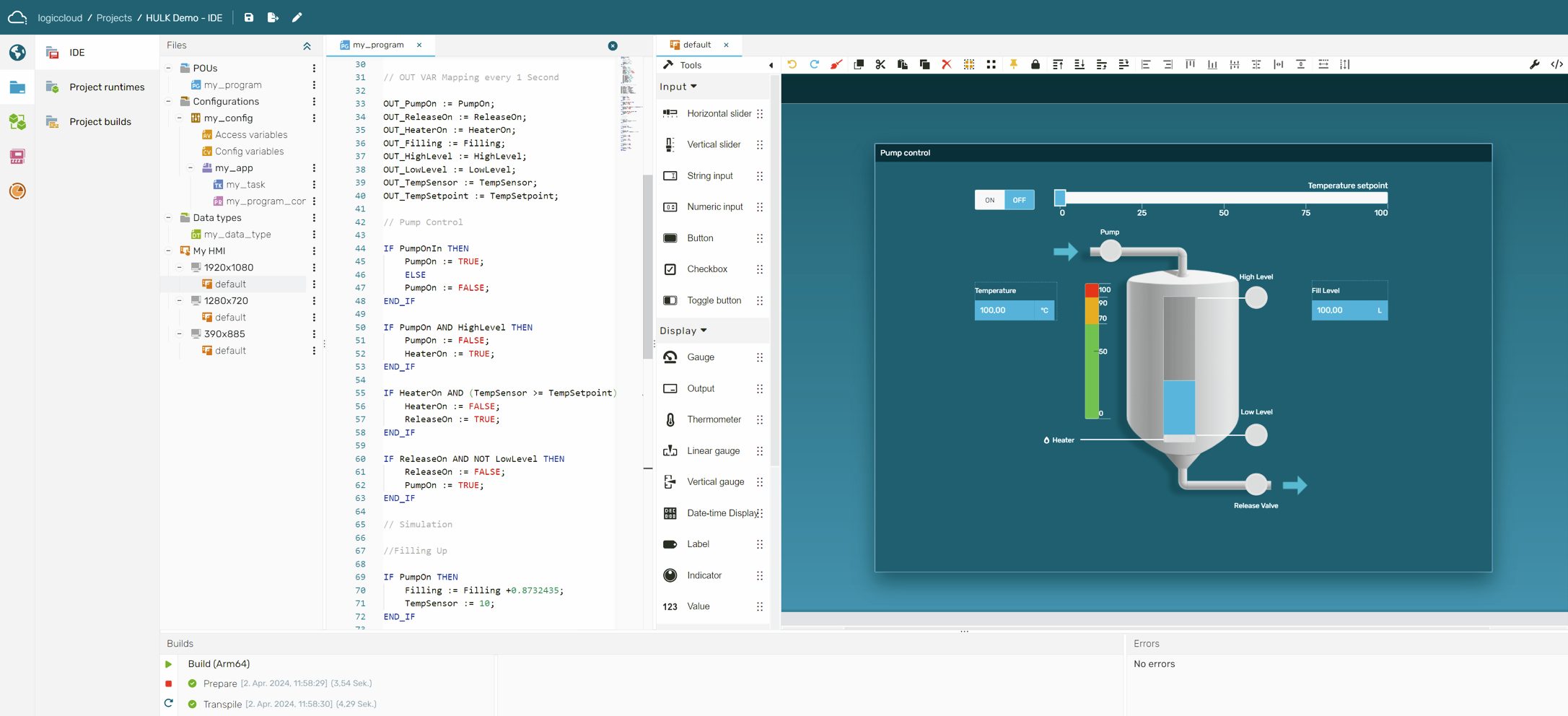

Zunächst werden im Model Builder Datensätze angelegt, die es dann später im Rahmen eines angelegten Projekts mit Domänenwissen Grenzwerten und Regeln anzureichern gilt. Die importierten Datensätze – z.B. im CSV-Format direkt aus der SPS kommend oder aus anderen Datenbanken – werden automatisch visuell aufbereitet und als Kacheln dargestellt. Dabei werden die Daten mit Hilfe von statistischen Qualitätsindikatoren bewertet, so dass dem Anwender schon auf den ersten Blick ein Gefühl vermittelt wird, wie gut sich eine Datenspur überhaupt für Machine Learning eignet. „Der Ingenieur kann auf Anhieb nachvollziehen, wie gut die erfassten Daten sind.“ Im nächsten Schritt geht es dann um das Labeling der Daten, auch Tagging genannt. Wie gesagt wollen wir, dass Nutzer bewusst ihre Expertise einbringen“, unterstreicht Gaukstern erneut. „Und das beginnt schon an dieser Stelle.“ Dabei reichert der Nutzer ausgewählte Datenspuren mit seinem Prozess- und Maschinenwissen an. So können z.B. Zeitbereiche in den Daten markiert werden, um das Normalverhalten oder ein ungewünschtes Verhalten zu markieren. Auch spezielle Zustände im Prozess wie das Anlaufverhalten oder Störungen bzw. Fehler lassen sich entsprechend kennzeichnen. „Auf diese Weise entsteht ein mit dem Maschinen- und Prozesswissen angereicherter Datensatz.“, sagt Gaukstern. Weiter geht es mit dem Feature-Engineering: Hier kann der Nutzer auf Basis seines Domänenwissens mit wenigen Klicks eigene Features kreieren, anhand derer sich ein bestimmtes Verhalten in den Daten beschreiben lässt. Dabei bewertet der Nutzer die Relevanz der Daten und stellt sie gegebenenfalls in Relation zueinander – mit einfachen mathematischen Funktionen. „Die Mathematik findet komplett im Hintergrund statt.“

Automatisches Training der ML-Modelle

Nach diesen Schritten kann der Anwender bereits mit dem Training eines Machine-Learning-Modells starten. Dafür wird zuerst festgelegt was für ein Modell auf Basis des angereicherten Datensatzes trainiert werden soll: Ein Modell zur Anomalieerkennung, Klassifikation oder Fehlervorhersage. Anschließend kann der Nutzer die Auswahl der Variablen für das Modelltraining bei Bedarf schon einschränken, muss es aber nicht. Als letzten Schritt legt der Nutzer die Zielfunktion für das Modell fest. Dies erfolgt anhand der im Datensatz markierten Anomalien, Fehler oder anderer Zustände. Dann startet das automatische Modelltraining. Im Hintergrund werden dann für jede Datenspur im Datensatz bis zu 300 Features automatisch generiert, um den maximalen Informationsgewinn aus den Rohdaten zu erhalten. Es folgt eine Korrelationsanalyse, um die relevanten Features für das Modelltraining zu extrahieren. Dann startet das eigentliche Modelltraining, bei dem unterschiedliche ML-Verfahren mit unterschiedlichen Feature-Sets trainiert, optimiert und validiert werden. Abschließend erhält der Nutzer eine Liste alternativer ML-Modelle, die nach Performance, Zuverlässigkeit, Ausführungszeit oder Datenmenge in eine Rangfolge gebracht werden können, so dass der Nutzer das für seinen Use Case passende Modell auswählen kann. Für jedes Modell ist nachvollziehbar welche Features verwendet werden und wie wichtig das jeweilige Feature für das Modell ist. Weidmüller verspricht hier größtmögliche Transparenz.

Das Modell ist niemals fertig

„Mehr muss der Anwender nicht tun“, resümiert Gaukstern. Ist der Nutzer mit dem Ergebnis nicht zufrieden, kann der Prozess iterativ durchlaufen werden und auch eine Weiterentwicklung der Modelle im Betrieb ist möglich. Im Prinzip sei ein Machine-Learning-Modell niemals wirklich fertig, so Gaukstern. „Einmal erstellt, lässt es sich stetig weiterentwickeln und verbessern.“ Natürlich hat Weidmüller die verwendeten ML-Verfahren nicht neu erfunden, sondern greift auf bewährte Bibliotheken zurück. „Bei unserem Industrial AutoML Tool nutzen wir Open-Source-Modelle für das maschinelle Lernen. Damit ist Weidmüller nicht alleine“, sagt Gaukstern abschließend. „Allerdings ist es uns gelungen, Machine Learning auf diese einfache Art und Weise den Ingenieuren bei Maschinenbauern und -betreiber zugänglich machen..“ (mby)