Die Digitalisierung hat einen Grad an Automatisierung und Überwachung von Prozessen ermöglicht, der zuvor undenkbar war. Trotzdem ist ihr Potenzial in vielen Bereichen noch lange nicht ausgeschöpft. Maschinen und Anlagen erzeugen während des Betriebs unzählige Daten. Viele davon stehen im direkten Zusammenhang mit den Anforderungen an einen Prozess. So müssen beispielsweise bei der Herstellung von Folien aus Kupfer oder Aluminium unter anderem fest definierte Temperaturen, Drücke und Zeiten eingehalten werden, um die hohe Qualität des Endprodukts sicherzustellen. Während jedes einzelnen Produktionsschritts (Schmelzen, Gießen, Walzen, Schneiden/Stanzen, Kaschieren…) fallen Daten an. Umfangreich erfasst und ausgewertet können diese für Prognosen herangezogen werden oder langfristig sogar neue Erkenntnisse zur Optimierung ganzer Produktionsverfahren liefern.

Im Dreiklang arbeiten

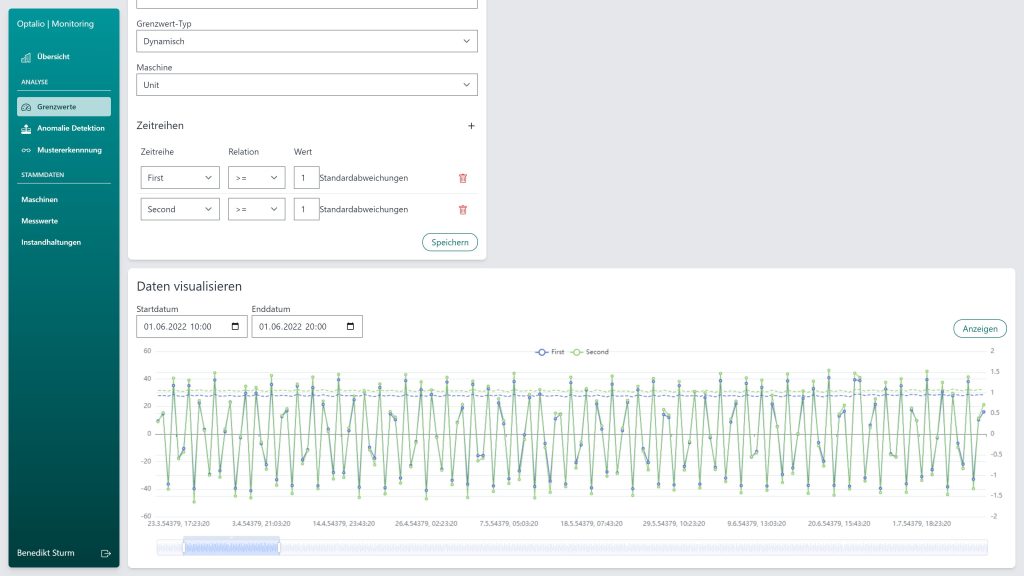

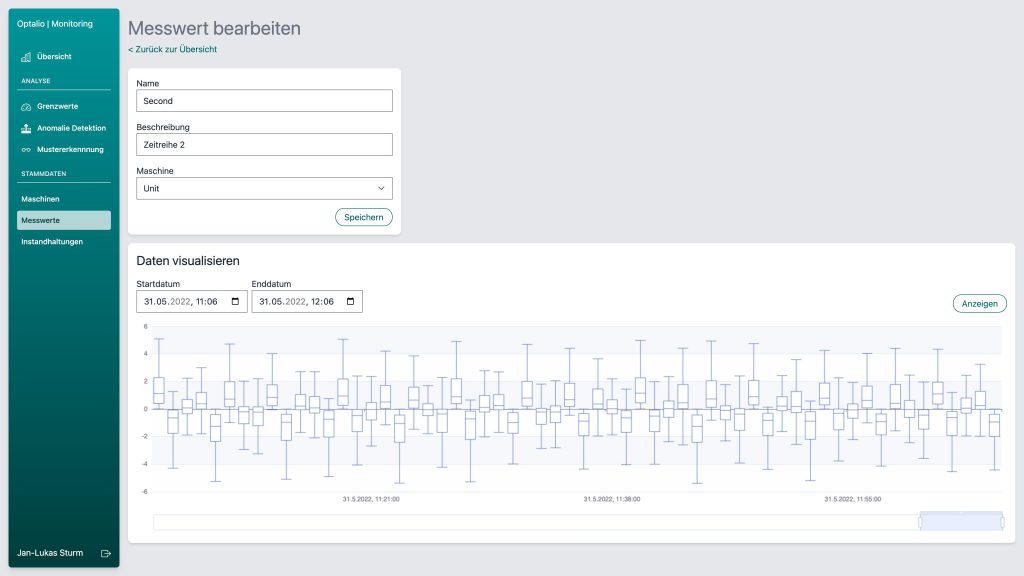

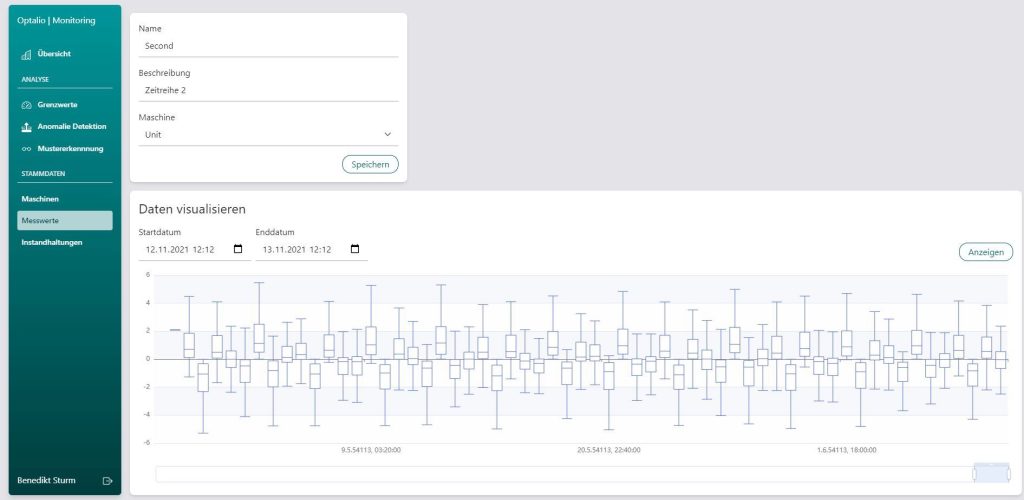

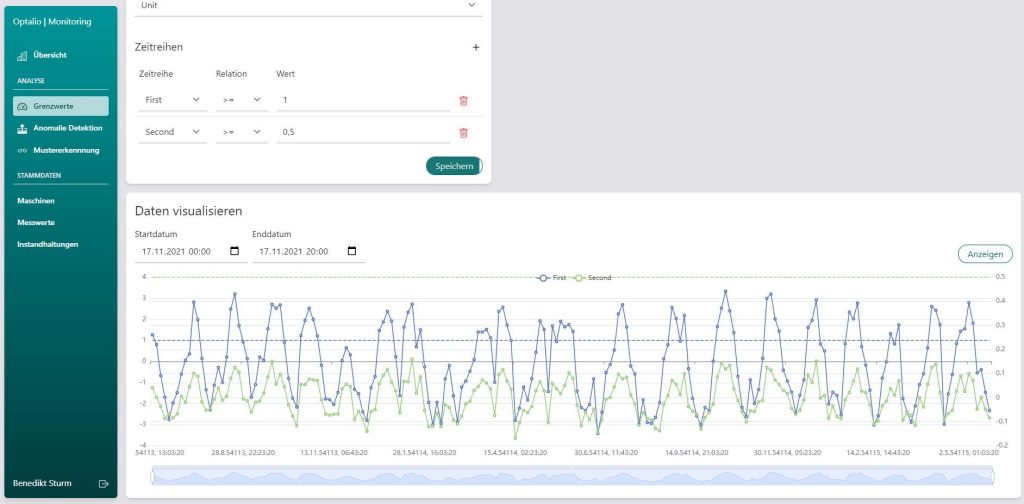

Um aus Maschinendaten sinnvolles Wissen zu ziehen, reicht es nicht, eine Maschine einfach an die IT anzuschließen und Daten zu erheben. Denn hier treffen mit analogen Produktionsanlagen (OT) und IT zwei unterschiedliche Welten aufeinander. Daher muss zunächst der Status quo in einem produzierenden Unternehmen ermittelt, anschließend die passende Infrastruktur implementiert werden, um schließlich die KI-gestützte Analyse durchführen zu können. Erst danach ist es möglich, umfassendes Datenmaterial zu erheben und sinnvoll auszuwerten. Optalio hat hierfür mit Partnern ´Solution Engineering´ entwickelt. Dabei wird zu Beginn genau eruiert, wie der aktuelle Stand in einem Unternehmen aussieht. Dazu gehören etwa der vorhandene Maschinenpark, die bestehende IT-Infrastruktur und ein Soll-Ist-Abgleich von Schnittstellen, Sensorik und weiterer Hardware. Nach der Sichtung vor Ort, die zwischen ein bis drei Tagen in Anspruch nimmt, erstellt Optalio ein Booklet, das neben der genauen Abbildung des Status quo auch eine umfassende Roadmap für alle weiteren Schritte beinhaltet. In der nächsten Stufe erfolgt die Implementierung der erforderlichen Hardware, um eine Industrial-IT-Infrastruktur umzusetzen und so die Datenerhebung zu ermöglichen. Dazu gehören neben Schnittstellen und Sensorik auch Firewalls zum Schutz des Netzwerks. Für die Speicherung der Daten dient entweder eine On-Premise-Lösung über einen Server direkt beim Kunden oder der Rückgriff auf eine sichere Cloud. Erst im letzten Schritt werden die Daten erhoben, aufbereitet und über die proprietäre KI von Optalio analysiert.

Punkte miteinander verbinden

Nach der Datenerhebung und -auswertung rückt die eigentlichen Herausforderungen der Maschinenoptimierung in den Fokus. Dazu zählen beispielsweise zu hoher Ausschuss, übermäßiger Energieverbrauch oder Leistungsschwankungen. Hier beginnt der Blick ins Unbekannte, denn bislang sind die Zusammenhänge verschiedener Parametern wie Druck, Temperatur, Viskosität, Drehzahlen, Durchfluss… nur anhand der Anforderungen an einen Prozess bekannt. Doch wie kommt es zu Ausschuss, wenn die physikalischen, chemischen und materialwissenschaftlichen Eigenschaften eigentlich klar und Anlagen genau darauf eingestellt sind?

Diese bislang unbekannten Zusammenhänge werden mithilfe von Data Engineering und KI erschlossen. Dabei sind die Ursachen individuell vom Unternehmen, der eingesetzten Maschinen und den Verfahren abhängig. Bereits kleinste Abweichungen zu Beginn eines Prozesses können zu Diskrepanzen in der Qualität des Endprodukts führen. Ziel ist es daher, solche Nuancen aus der Masse der verschiedensten Daten zu erkennen und logische Verknüpfungen zu entdecken. Konkret etwa Fragen wie: Welche Bedingungen herrschten vor, als es zu Ausschuss kam? Um Antworten zu finden, kommt es auf die Quantität und Qualität der Daten an. Je mehr und je hochwertiger die Daten sind, desto eher lassen sich nicht nur Korrelationen, sondern auch Kausalitäten erkennen.

Bündel an Vorteilen

Selbst Produktionsverfahren, die auf den ersten Blick einfach erscheinen, erfolgen in hochkomplexen Systemen. Um spürbare Ergebnisse zu erzielen, muss daher für die Datenerhebung und Analyse mit Zeiträumen von mehreren Monaten bis Jahren gerechnet werden. Steht jedoch einmal die Infrastruktur zur Datenerhebung und -analyse, kann diese automatisch im Hintergrund mitlaufen und auch jederzeit erweitert werden.