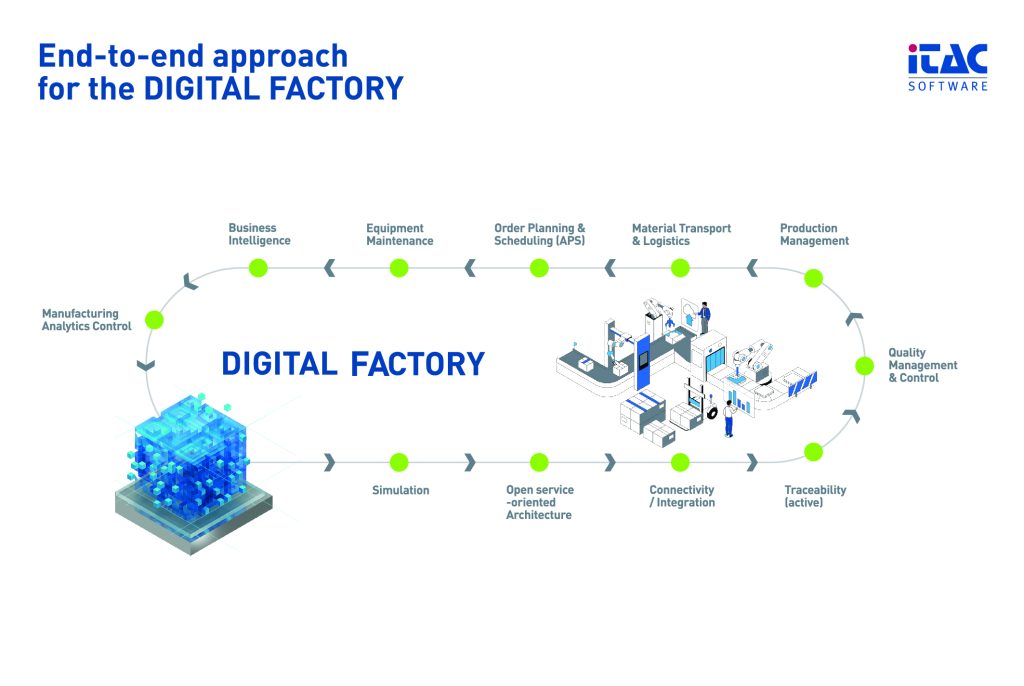

Gemäß der Vision von Industrie 4.0 sollen moderne Ansätze aus der Informations- und Kommunikationstechnik auf die Operational Technology (OT) übertragen werden. In der Praxis leitet sich daraus die Notwendigkeit ab, die heterogene Landschaft an Systemen zur Steuerung, Überwachung und Verbesserung interoperabel zu vernetzen. Die Realisierung verspricht neue Möglichkeiten, die industrielle Produktion zu organisieren. Die Umsetzung der Vision hinkt jedoch den Erwartungen hinterher. Die Realisierung kommt einem grundlegenden Paradigmenwechsel gleich, der aufgrund hoher technischer Komplexität und einer großen Anzahl beteiligter Stakeholder schwer umzusetzen ist. Die Stuttgarter Maschinenfabrik am ISW ist als konkretes Umsetzungsprojekt für Industrie 4.0 ausgerichtet. Ziel ist es, Realisierungshürden zu überwinden und neues Potenzial aufzuzeigen, das durch den Vollzug des Paradigmenwechsels ausgeschöpft werden kann.

Schnittstellen, Protokolle und Datenformate

Ausgangspunkt und oftmals entscheidende Einstiegshürde, um die Transformation hin zu einem digitalisierten Unternehmen zu meistern, ist die Konnektivität – sprich die Anbindung von Software-Anwendungen, Geräten, Sensoren und Maschinen für einen durchgängigen Datenaustausch. Denn ohne eine umfangreiche Datenbasis können datengetriebene Anwendungen im Sinne von Industrie 4.0 nicht funktionieren. Problematisch ist, dass die Daten für gewöhnlich von einer Vielzahl an Systemen, mit vielen verschiedenen und teilweise proprietären Schnittstellen, in unterschiedlichen Datenformaten und Protokollen abgegriffen werden müssen. Um Konvergenz zwischen der Vielzahl an Systemen, Schnittstellen und Protokollen der OT und Anwendungen der IT zu erreichen, müssen die Daten auf unterster Ebene erfasst, aufbereitet und für einen einheitlichen Datenaustausch bereitgestellt werden.

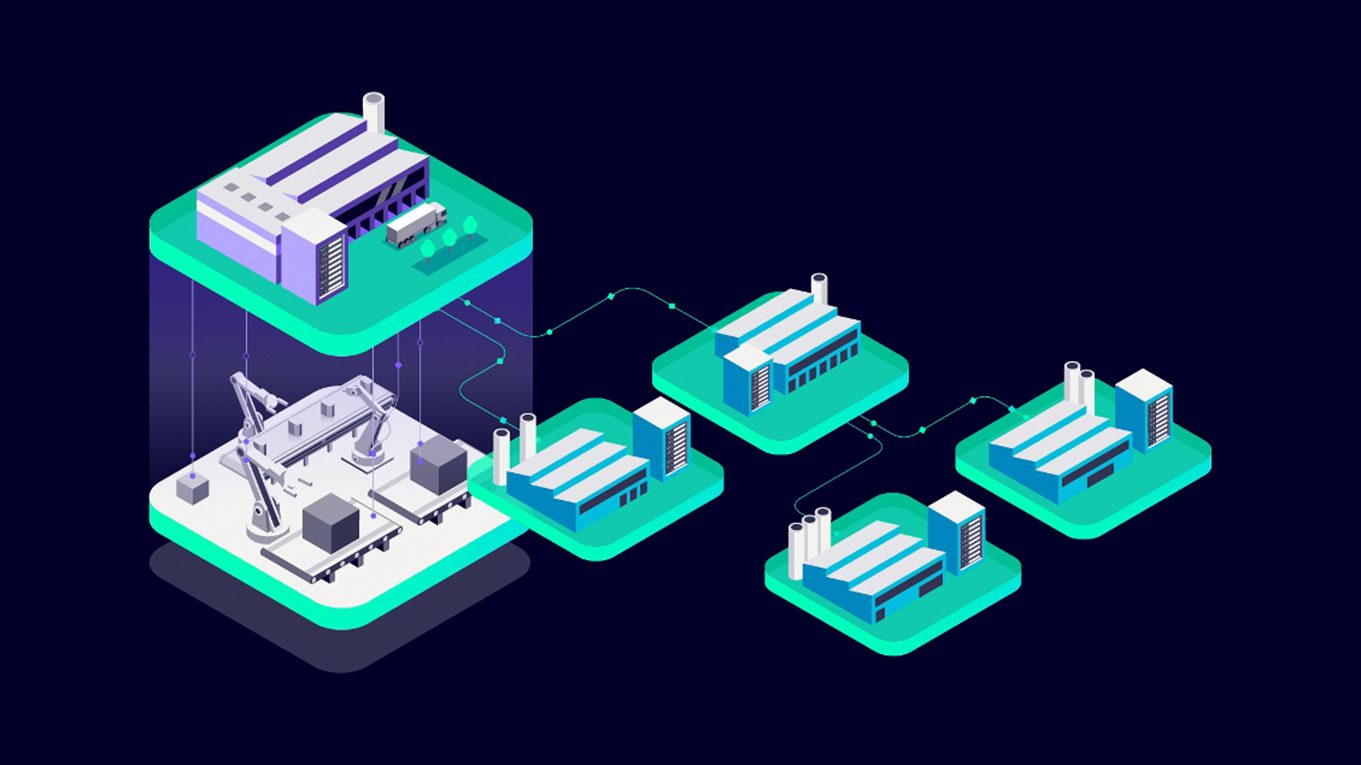

Hierzu werden oftmals sogenannte IoT-Gateways als Bindeglied eingesetzt. Dabei handelt es sich häufig um zusätzliche Hardware, die am Rande (Edge) des Produktions-Netzwerks installiert wird und die Daten der angebundenen Geräte an eine übergeordnete Datenbank oder einen Broker in einer Cloud sendet. Sind die Daten einmal an zentraler Stelle gespeichert, können sie dort mit Hilfe von Analyseplattformen ausgewertet oder von anderen Anwendungen abgegriffen und verarbeitet werden.

Insbesondere für kleine und mittelständische Unternehmen (KMU) birgt diese Architektur jedoch eine Vielzahl an Risiken und Nachteilen. Zum einem muss zusätzliche Hardware auf Produktionsebene integriert werden. Bei einer großen Anzahl an anzubindenden Geräten ist dieser Umstand mitunter ein enormer Kostenfaktor und sorgt für zusätzliche Komplexität. Verwendet man darüber hinaus Cloud-Dienste, begibt man sich in die Abhängigkeit externer Firmen. Ein Wechsel des Anbieters ist dann zu einem späteren Zeitpunkt oft nicht mehr einfach möglich und birgt Risiken, das Knowhow und die bisher gesammelten Daten zu verlieren. Zusätzlich besteht die Gefahr von Downtimes, Datenlecks und Hackerangriffen. Die Realisierung und Integration datenbasierter Methoden in bestehende Produktionssysteme verlangt zudem insbesondere KMU einiges ab. Oftmals mangelt es an personellen Ressourcen oder Mitarbeitern mit dem erforderlichen Knowhow, um solche Anwendungen effizient umzusetzen sowie mittel- und langfristig zu pflegen bzw. zu aktualisieren. Der Einsatz datenbasierter Services und Dienste im Kontext der Digitalisierung wird jedoch zukünftig fundamentaler Bestandteil der Kompetenz von Unternehmen sein müssen, bilden sie doch die Grundlage für neue Geschäftsmodelle und sind folglich von entscheidender Bedeutung für den langfristigen Erfolg.

Um durchgängige Datenketten aufzubauen und die dabei zwangsläufig aufkommende Komplexität beherrschbar zu machen, bedarf es daher einer effizienten, geräteunabhängigen und flexiblen Anwendung, die in der Lage ist Daten zuverlässig von verteilten Quellen, mit verschiedensten Schnittstellen und Protokollen abzugreifen, zu verarbeiten und bereitzustellen. Dabei muss die Anwendung auch von unerfahrenen Anwendern einfach nutzbar sein und sich an die unternehmensspezifischen Anwendungsfälle anpassen lassen. Collectu bildet all diese Anforderungen in einer einzigen Anwendung ab. Durch den Einsatz von Collectu gewinnen Unternehmen Flexibilität und Unabhängigkeit. Einzelne Komponenten, z.B. eine Anwendung zur Visualisierung von Daten, können vergleichsweise einfach ausgetauscht, ergänzt oder an spezifische Besonderheiten des vorliegenden Szenarios angepasst werden. Die hierdurch gewonnene Transparenz und Offenheit der Gesamtarchitektur reduzieren zudem die Gefahr von ungewollten Abhängigkeiten und ermöglichen den Unternehmen die Daten eigenständig zu verwalten und die darin befindlichen Informationen zu schützen.

Modulare Plattform für Durchgängigkeit

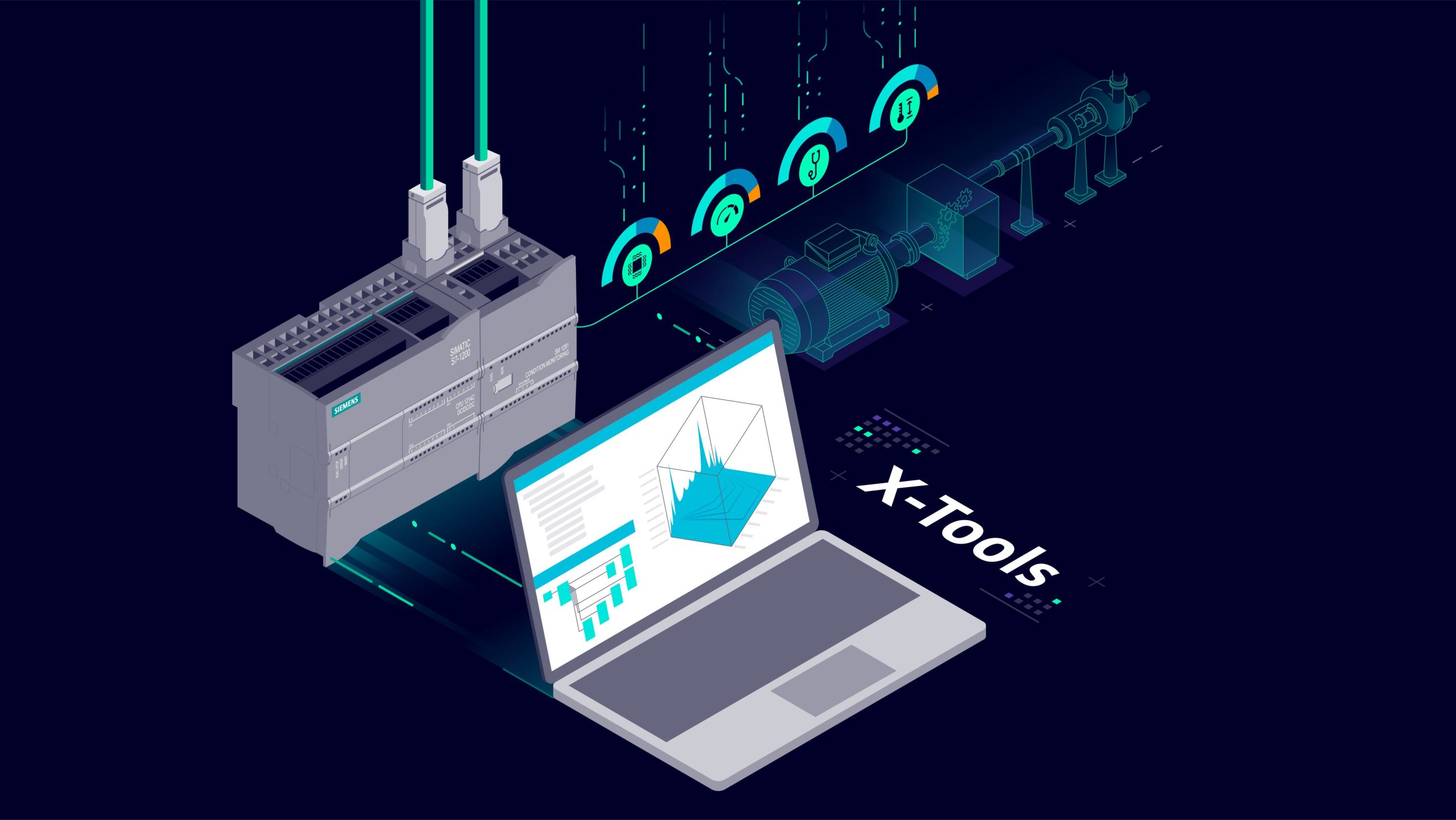

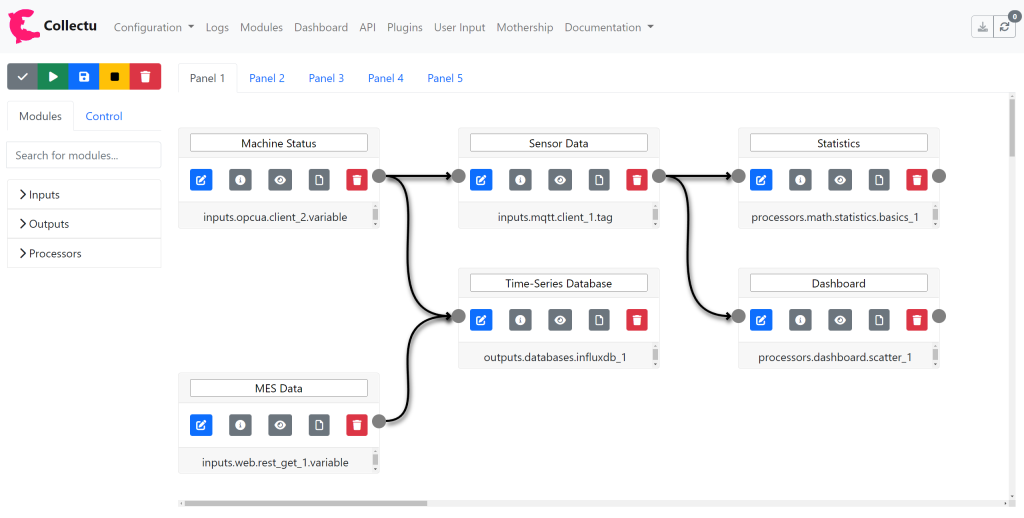

Collectu ist eine software-basierte und geräteunabhängige Anwendung, die es ermöglicht Daten von verschiedenen Quellen aufzunehmen, mit Daten anderer Quellen zu kombinieren, diese zu verarbeiten (z.B. zu filtern oder erste statistische Analysen zu erstellen) und anschließend an definierte Ziele, wie eine Zeitreihen-Datenbank zu senden. Die Anwendung kann standardmäßig sowohl in einem Container, in der Cloud, auf IoT-Devices als auch direkt auf einem Steuerungs-PC ausgeführt werden. Ein wesentliches Alleinstellungsmerkmal gegenüber vergleichbaren Produkten ist dabei, dass die Anwendung in Python programmiert wurde. Die Programmierung in Python, als Quasi-Standard im Bereich der Datenanalyse und Machine Learning, bietet den Vorteil, dass auf einer Vielzahl an bereits existierenden Bibliotheken aufgebaut werden kann. Das ermöglicht die einfache Erweiterung der Anwendung mit zusätzlichen Funktionen, Schnittstellen und Algorithmen. Dadurch kann schnell und flexibel auf neue Anforderungen reagiert und das Verhalten auf spezifische Anwendungsfälle zugeschnitten werden. Python ist darüber hinaus, unter anderem aufgrund der guten Lesbarkeit, für Anfänger einfach zu erlernen und der Programmcode nachvollziehbar. Dadurch werden auch unerfahrene Anwender dazu befähigt, die Anwendung ihren Wünschen und Anforderungen entsprechend anzupassen.

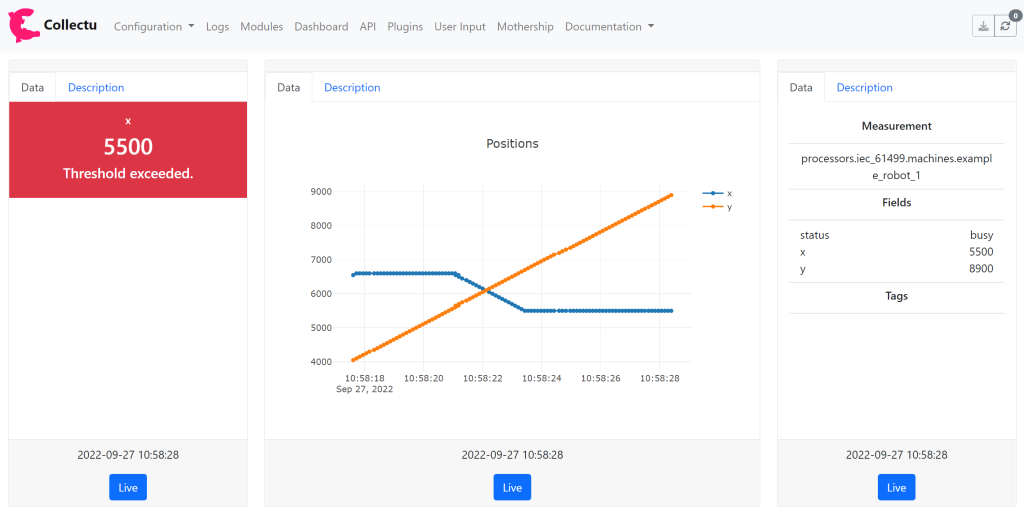

Die zugrundeliegende Architektur der Anwendung zielt auf eine Modularisierung der beinhalteten Funktionalitäten ab. Collectu kommt von Haus aus mit einer Vielzahl an vorgefertigten Modulen, die neben der Erfassung von Daten mittels OPC UA, MQTT, REST und vielen mehr, auch statistische Analysen und die Anwendung von Machine Learning Algorithmen ermöglichen. Darüber hinaus können die erfassten Daten etwa in InfluxDB, MongoDB, PostgreSQL und Excel- bzw. CSV-Dateien gespeichert oder mittels einer HTTP-Anfrage direkt an andere Anwendungen übertragen werden. Mit Hilfe der beschriebenen Module können ganz ohne Programmierung persönliche Daten-Pipelines, eine Verkettung mehrerer Module, über die webbasierte grafische Benutzeroberfläche aufgesetzt, parametriert und ausgerollt werden. Einmal erstellt, werden die Daten-Pipelines automatisiert ausgeführt und erfordern keinen weiteren manuellen Eingriff. Um die Erstellung von Daten-Pipelines zu unterstützen, diese frühzeitig verifizieren zu können und unmittelbar Einblicke in die erfassten Daten zu gewähren, bietet Collectu darüber hinaus die Möglichkeit direkt personalisierte Dashboards zu erstellen. Für diesen Zweck stehen ebenfalls Module zur Verfügung, die ganz ohne Programmierung, in eine Pipeline integriert werden können und auf der grafischen Benutzeroberfläche entsprechende Visualisierungen generieren.

Die vielseitigen Einsatzmöglichkeiten, die integrierten Funktionen und die Erweiterbarkeit der Anwendung verdeutlichen, wie eine zukunftsorientierte Architektur zur Erfassung, Verarbeitung und Auswertung von Daten gestaltet werden kann. Dabei demonstriert Collectu eine einfache Bedienbarkeit bei einer gleichzeitig hohen Effizienz und Flexibilität. Durch die grundlegende Offenheit ist Collectu ein passender Wegbereiter zu einer flexiblen und digitalisierten Produktion.

Stuttgarter Maschinenfabrik

Teil 1: Die Stuttgarter Maschinenfabrik

(SPS-MAGAZIN 10/2022)

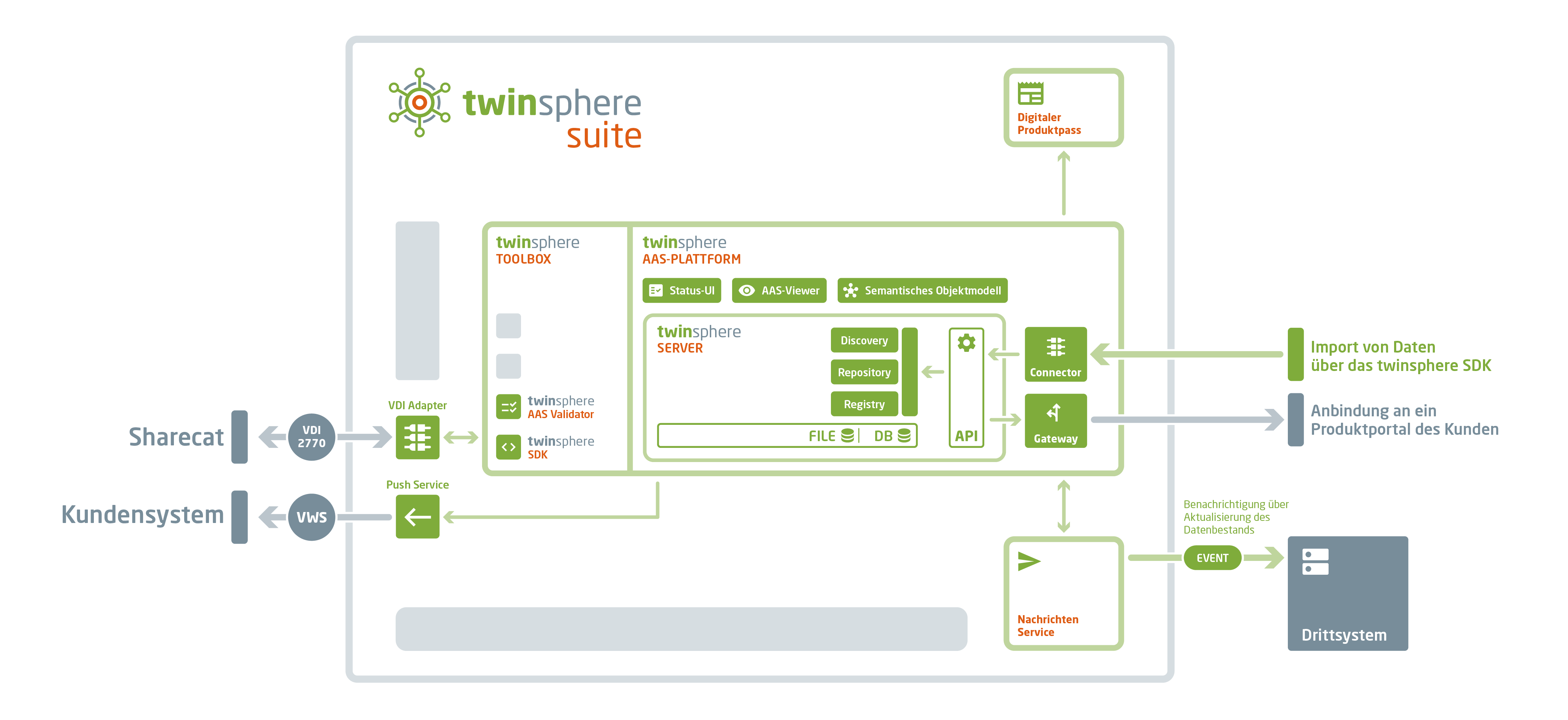

Teil 2: Abbildung durch Verwaltungsschalen

(SPS-MAGAZIN 11/2022)

Teil 3: Durchgängige Daten-Pipelines

(SPS-MAGAZIN 13/2022)

Teil 4: Echtzeitsteuerung aus der Cloud

(SPS-MAGAZIN 1/2023)

Teil 5: Safety aus der Cloud (SPS-MAGAZIN 2/2022)

Teil 6: Cloud Manufacturing (SPS-MAGAZIN 3/2022)